Die Idee für das Projekt TPTP-Web-TEST, im

Folgenden kurz als Web-TEST bezeichnet, entstand durch den beruflichen

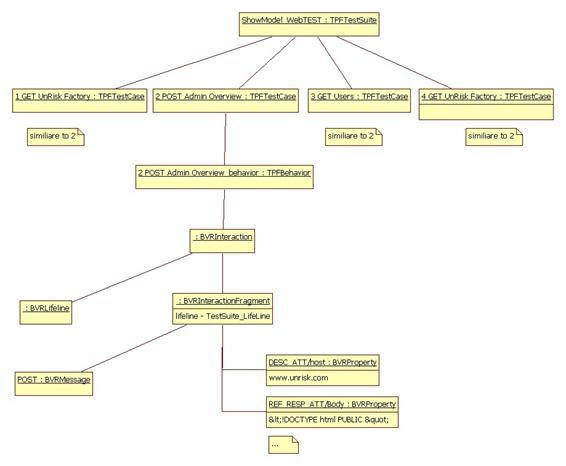

Hintergrund des Autors der vorliegenden Arbeit. Der Autor, Günter Öller, ist

als Webentwickler bei der Firma MathConsult GmbH [3] an der Entwicklung des

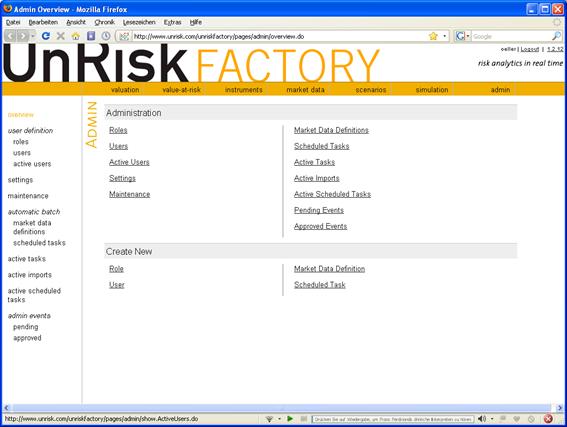

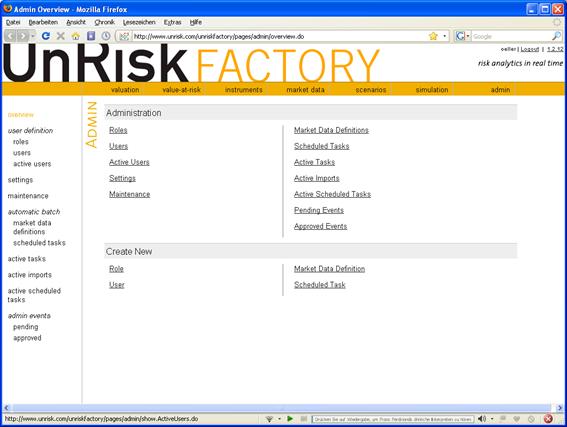

Produkts UnRisk-FACTORY [4] beteiligt. UnRisk-FACTORY ist eine HTML-basierte

Intranetanwendung. In dieser Webanwendung werden die HTML-Seiten von einem Webserver

generiert. Im Folgenden wird diese Art von Anwendung als HTML-basierte

Webanwendung bezeichnet.

UnRisk-FACTORY wird von Banken und anderen

Finanzdienstleistern im Intranet eingesetzt, um den Wert von Finanzprodukten

schätzen und überwachen zu können.

Bei der Entwicklung von UnRisk-FACTORY ist

es in der Vergangenheit oft zu Problemen gekommen. Neue Versionen des Produkts

enthielten Fehler, die in Vorgängerversionen bereits ausgebessert waren, was

unter anderem zu einer Verschlechterung des Produktimages führte. Das Problem

ist, dass es bei Änderungen eines Dienstes oft zu Fehlern in einem anderen

Dienst kommt. Abbildung 1.1 veranschaulicht dieses Problem.

Abbildung

1.1: Unerkannter Fehler durch eine

neue Version der Anwendung

Wie Abbildung

1.1 darstellt, kann es durch eine Änderung eines Dienstes

A zu einem Fehler in einem darauf aufbauenden Dienst B kommen, obwohl B nicht

geändert und deshalb vielleicht nicht neu getestet wurde. Um dem vorzubeugen, kann

man ein Testverfahren verwenden, das die unveränderten Dienste einer neuen

Version mit der Vorgängerversion vergleicht. Diese Art des Testens wird als

Regressionstesten bezeichnet und im Kapitel 2.3 „Regressionstests

von HTML-basierten Webanwendungen“ näher beschrieben.

Für UnRisk-FACTORY wurde aufgrund dieses

Fehlertyps entschieden, dass Regressionstests durchgeführt werden müssen. Um

dies zu bewerkstelligen, wurde eine Mitarbeiterin als Tester eingesetzt, um die

Vergleiche manuell durchzuführen. Da sich diese Arbeit als sehr zeitaufwendig

und für den Tester demotivierend herausstellte, wurde dem Autor dieser Arbeit

die Aufgabe übergeben, ein unterstützendes Testwerkzeug zu suchen.

Zu

diesem Zweck wurden, unter anderem, folgende Werkzeuge getestet:

- Rational

Functional Tester von IBM [5]

- NeoLoad von NeoTys [6]

- vTest von Verisium [7]

- eValid von Software Research [8]

- JMeter von Apache [9]

- BadBoy von

Badboy [10]

- PureTest von

Minq Software [11]

- das

Open-Source Eclipse-Plug-In Solex [12]

- die

Open-Source Eclipse-Test-Plattform TPTP (Test and Performance Tools

Platform) [13]

Bei

der Evaluierung dieser Werkzeuge wurden jedoch folgende Punkte als unzureichend

festgestellt:

- Die professionelleren Werkzeuge sind auf Performanz- bzw.

Last-Tests spezialisiert und bieten wenig Unterstützung für Funktions- und

Regressionstests, die sich auf den Inhalt von HTML-Seiten beziehen.

- Funktions- und Regressionstests im Webumfeld werden lediglich

zum Überprüfen von HTTP-Response-Codes beziehungsweise einzelner Texte

oder reguläre Ausdrücke in den HTML-Seiten verwendet.

- Keines der getesteten Werkzeuge bot eine ausreichende

Unterstützung bei der automatischen Erzeugung von Testbedingungen.

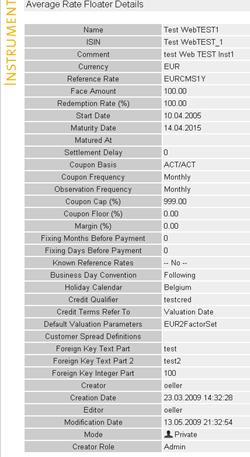

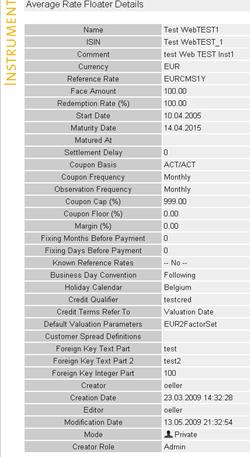

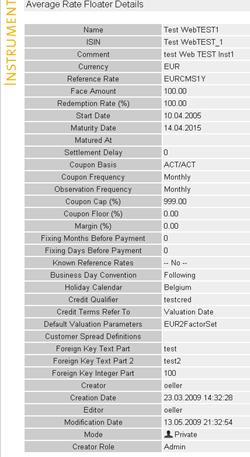

Zur Erklärung des letzten Punkts: UnRisk-FACTORY

verwendet häufig HTML-Seiten mit einer zweispaltigen Tabelle wie in Abbildung 1.2 gezeigt, um Information anzuzeigen.

Abbildung

1.2: Zweispaltige Tabelle in UnRisk-FACTORY mit Attributen als Name-Wert-Paare

Wobei die erste Spalte den Namen eines

Attributes und die zweite Spalte den dazugehörigen Wert enthält. Ein

verwendbares Werkzeug muss diese Einheitlichkeit ausnützen und den Test für

alle diese Attribute mit wenigen Schritten erstellen können. Eine bedeutende

Randbedingung ist dabei, dass die Anzahl der nötigen Schritte nicht von der

Anzahl der Zeilen in der angezeigten Tabelle abhängt.

Weiters wurden Werkzeuge getestet, die es

erlauben, einen Schnappschuss einer HTML-Seite aufzuzeichnen und diesen

Schnappschuss dann mit der Testausführung zu vergleichen. Dieser Bildvergleich hat

jedoch den Nachteil, dass sich kein Parameter einer Seite ändern darf, damit

der Tests erfolgreich verläuft. In UnRisk-FACTORY und in vielen ähnlichen

Anwendungen wird jedoch ein Änderungsdatum angezeigt, dass sich von Testaufnahme

zu Testausführung verändert.

Eine weitere Alternative sind Testwerkzeuge,

die es gestatten, eine maximale Veränderungsrate anzugeben. Diese Rate gibt an,

zu wie viel Prozent sich eine HTML-Seite von der Aufzeichnung zur

Testausführung verändern darf. Leider wurde auch dieses Verfahren als unzulänglich

für UnRisk-FACTORY eingestuft. Beim Testen von UnRisk-FACTORY ist es wichtig,

den Wert bestimmter Felder genau zu überprüfen, andere Felder, wie etwa ein

Änderungsdatum, sollen hingegen nicht überprüft werden.

Da keines dieser

Werkzeuge überzeugen konnte, entschied sich MathConsult, die Tests weiter

manuell durchzuführen. Der Autor dieser Arbeit wurde allerdings durch den

Evaluierungsprozess auf die Eclipse-Test-Plattform TPTP aufmerksam. Dieses

Framework bietet bereits die grundlegenden Dienste zum Durchführen von

Regressionstests. TPTP unterstützt sowohl das Aufzeichnen von Verwendungsszenarien

von HTML-basierten Webapplikationen, als auch das Verwalten und Abspielen dieser

Szenarien. Im Wesentlichen fehlen lediglich die Funktionen, um Testbedingungen für

den Inhalt von HTML-Seiten zu verwalten und diese während der Testausführung zu

überprüfen. Da TPTP darauf ausgerichtet ist Erweiterungen zu ermöglichen, und

der Quellcode unter der Eclipse-Public-Licence (EPL) [14]

zur Verfügung steht, ist es möglich, die fehlenden Dienste hinzuzufügen. Aufgrund

dieser Überlegung wurde das Projekt TPTP-Web-TEST gestartet.

Im Rahmen des Projekts TPTP-Web-TEST sollen

drei Ziele miteinander vereint werden:

- Es soll ein Testwerkzeug für Regressionstests von

HTML-basierten Webanwendungen erstellt werden. Das Unternehmen MathConsult

GmbH soll durch dieses Werkzeug beim Regressionstesten der Anwendung

UnRisk-FACTORY unterstützt werden.

- Das Testwerkzeug soll auch für andere HTML-basierte Webanwendungen

einsetzbar sein und von den jeweiligen Benutzern angepasst werden können.

- Das Testwerkzeug soll sich in TPTP integrieren und neue

Versionen von TPTP unterstützten. Deshalb muss die Entwicklung von

Web-TEST mit dem TPTP-Team abgesprochen werden.

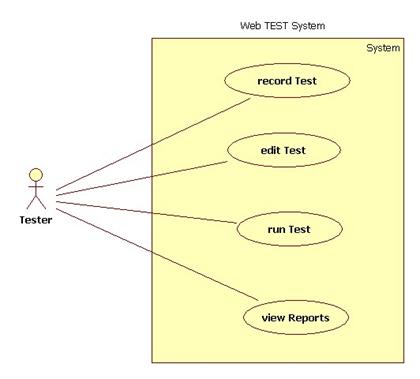

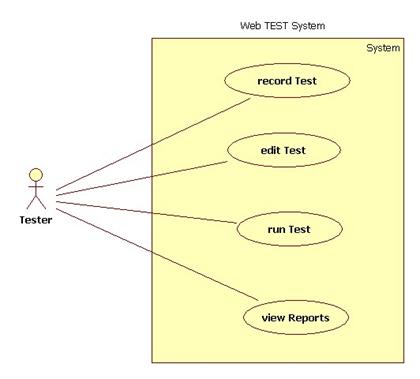

Die Firma MathConsult benötigt

ein Werkzeug, das den in Abbildung

1.3 dargestellten Anwendungsfall zum Testen von UnRisk-FACTORY

unterstützt.

Abbildung

1.3: Geforderter Anwendungsfall für Web-TEST

Abbildung

1.3 zeigt, aus welchen Schritten der geforderte

Testprozess besteht:

- Der Tester nimmt eine zu gewährleistende Funktionalität auf.

Dazu spielt er diese Funktionen in der zu testenden HTML-basierten

Webapplikation durch und lässt einen Prozess mitlaufen, der alles

protokolliert.

- Der Tester bearbeitet den so erstellten Test. Er führt Variablen

für die Testausführung ein und legt Testbedingungen für den Inhalt von

HTML-Seiten fest.

- Ein Benutzer (der Tester selbst oder ein Entwickler) kann durch

Umstellen der Applikations-URL den Test mit verschiedenen Versionen der

Applikation abspielen.

- Nach der Beendigung einer Testausführung kann sich der Benutzer

den Testbericht anzeigen lassen.

Wesentlich ist der Schritt 2, in dem die

Testbedingungen erstellt werden. Gerade in diesem Punkt muss sich Web-TEST von

den evaluierten Testwerkzeugen unterscheiden. Folgende Funktionen müssen

angeboten werden:

- Es muss möglich sein, eine Bedingung für den Inhalt eines

speziellen Elements einer HTML-Seite zu erstellen.

- Es muss möglich sein, Bedingungen für alle HMTL-Seiten mit

gleicher Struktur aber unterschiedlichen Inhalten in einem Schritt zu

generieren.

Die letzte der beiden hier angesprochenen

Funktionen hilft dem Tester von UnRisk-FACTORY außerordentlich. Wie zuvor schon

erwähnt, zeigt UnRisk-FACTORY sehr viele Informationen über zweispaltige

Tabellen an. Wobei jede Zeile eine Eigenschaft eines in UnRisk-FACTORY

verwendeten Objekts beschreibt. Jede Eigenschaft hat einen Namen und einen

Wert. Bei der Testausführung müssen dann die Objekteigenschaften die gleichen

Werte wie bei der Testaufnahme haben.

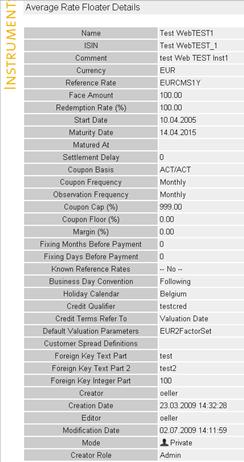

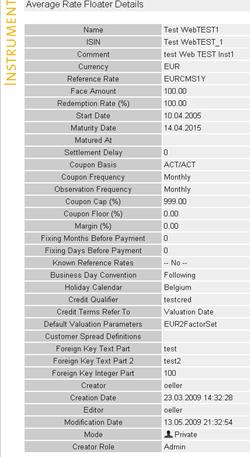

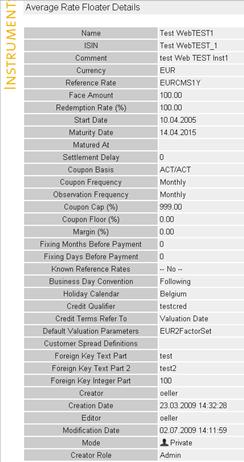

Abbildung

1.4: Objekteigenschaften einer

Testvorlage und einer Testausführung in UnRisk Factory

Abbildung

1.4 zeigt zweimal den gleichen Ausschnitt einer

HTML-Seite von UnRisk-FACTORY. Dabei wird auf der linken Hälfte der Zustand dargestellt,

der in einer älteren UnRisk-FACTORY Version als richtig festgehalten wurde. Auf

der rechten Hälfte wird der Zustand der HTML-Seite dargestellt, der beim manuellen

Durchführen eines Regressionstests mit einer neuen Version von UnRisk-FACTORY

angezeigt wird. Wenn man die Zeilen der

dargestellten Tabellen vergleicht, dann erkennt man, dass diese bis auf die

Zeile „Modification Date“ identisch sind. Somit ist der manuelle

Regressionstest erfolgreich verlaufen. Wenn man das tatsächlich und gewissenhaft

macht, dann bemerkt man schnell, dass das manuelle Überprüfen der Werte sehr

zeitaufwendig und fehleranfällig ist. Unter anderem fehleranfällig, weil man

bei der großen Anzahl der Zeilen und den oft ähnlichen Werten leicht etwas übersieht.

Weiters ist zu beachten, dass es hunderte verschiedene Objekttypen und damit

hunderte dieser Tabellen in UnRisk-FACTORY gibt, die getestet werden müssen.

Die automatische Erzeugung der

Testbedingungen aus der Testvorlage und der programmgesteuerte Vergleich während

der Testausführung sind deshalb eine wesentliche Erleichterung für den Tester.

Dabei wird nicht nur der Tester entlastet, sondern auch die Qualität des Tests

gesteigert.

Diese Arbeit beschreibt die Umsetzung der

zuvor beschriebenen Anforderungen im Rahmen des TPTP-Web-TEST-Projekts und ist inhaltlich

wie folgt aufgebaut:

§

In Kapitel 2 „Methoden

zum funktionalen Testen von

HTML-basierten Webanwendungen“ werden die verwendbaren Testmethoden vorgestellt,

und es wird festgelegt, welche Testmethode das Werkzeug Web-TEST verwendet.

§

In Kapitel 3 „Die Verwendung von Web-TEST“ wird das Werkzeug Web-TEST aus Benutzersicht vorgestellt.

Mit Hilfe eines Anwendungsfalls wird demonstriert, wie ein Benutzer Web-TEST verwendet.

§

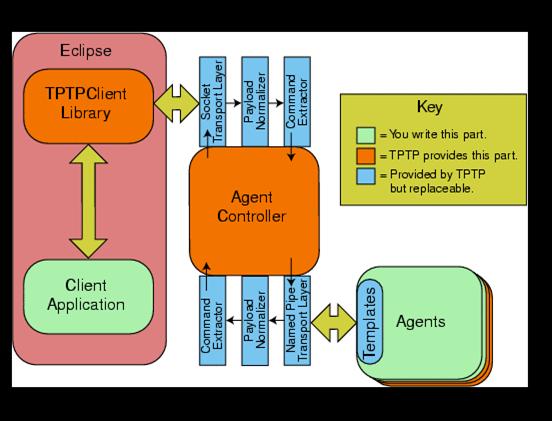

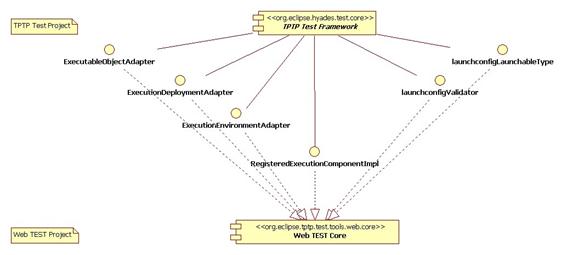

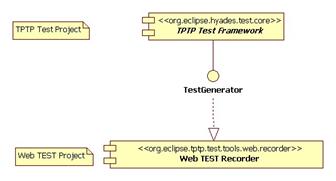

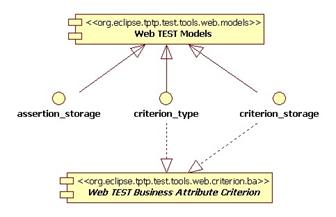

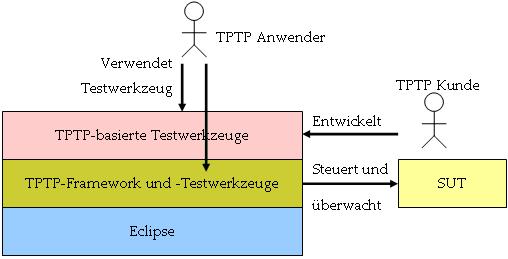

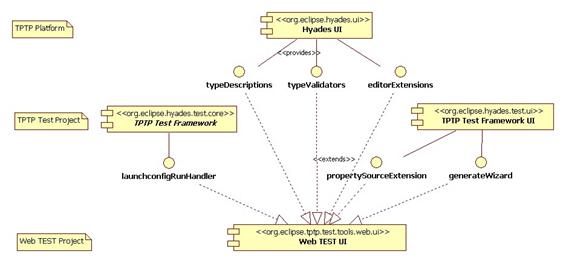

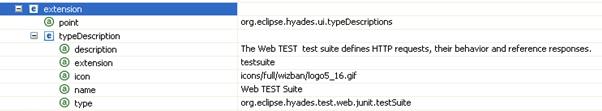

In Kapitel 4 „Das TPTP-Framework“ wird das von Web-TEST verwendete Eclipse-Test-Framework

TPTP vorgestellt.

§

In Kapitel 5 „Die Umsetzung von Web-TEST“ werden die Umsetzung und die Schnittstellen von

Web-TEST besprochen.

§

In Kapitel 6 „Ausblick und Schlussfolgerung“ wird ein Überblick über mögliche Erweiterungen

gegeben. Abschließend wird in diesem Kapitel die persönliche Einschätzung des Autors

für das Werkzeug Web-TEST dargelegt.

Gebräuchliche und in der

Informatik übliche Fachausdrücke, Abkürzungen und Fremdwörter werden im Text

nicht speziell gesetzt und es wird kein Glossar aller verwendeten Ausdrücke

angeboten. Nicht gebräuchliche und in der Informatik unübliche Fachausdrücke,

Abkürzungen und Fremdwörter werden bei ihrer ersten Verwendung im Text erklärt

oder mit einem Literaturverweis versehen. Weiters werden diese Ausdrücke bei

ihrer ersten Verwendung in kursiver Schrift gesetzt. Bei jeder weiteren

Verwendung werden diese Ausdrücke nicht nochmals erklärt und sie werden dann

nicht mehr speziell gesetzt. Zusammengesetzte Fremdwörter und Eigennamen werden

mit Bindestrich dargestellt. Außerdem wird bei der ersten Übersetzung eines

englischen Begriffs (beispielsweise aus Tabellen, Grafiken oder von Fachbegriffe) die englische Form in

Klammer nach der Übersetzung notiert. Diese Notation wird auch verwendet, wenn

im Text Synonyme für Begriffe aus Tabellen und Grafiken benutzt werden. Namen

von Elementen in grafischen Oberflächen (Labels), Ordnernamen, Pfade und Werte von Attributen aus

Grafiken und Tabellen werden mit Hilfe von Anführungszeichen gekennzeichnet.

Das Testen von Webanwendungen stellt sich

aufgrund der oft mehrschichtigen Architektur etwas komplexer dar als bei

normalen Desktop-Anwendungen. Auch UnRisk-FACTORY ist eine mehrschichtige

Webanwendung, wobei die in Abbildung

2.1 dargestellte dreischichtige Webarchitektur verwendet

wird.

Abbildung

2.1: Die Standard-Drei-Schichten-Webarchitektur

Abbildung

2.1 zeigt die Standard-Drei-Schichten-Webarchitektur.

Diese besteht aus Datenhaltung (Storage System), Geschäftslogik (Business Layer)

und Webserver (Web Server). Die einzelnen Schichten sind hierarchisch

angeordnet und voneinander abhängig. Daraus ergibt sich auch, dass ein stufenweises

Testverfahren benötigt wird, um zuerst die Einzelkomponenten und später das

Gesamtsystem testen zu könne. Das Testen

von Webanwendungen wird deshalb, wie bei komplexen Software-Projekten üblich,

in mehrere Phasen unterteilt [1]:

- Test der

Spezifikation (Requirement Testing): Testen

der Spezifikation auf Widerspruchsfreiheit, Vollständigkeit und Klarheit.

- Modultest (Unit Testing): Testen von einzelnen Klassen und später Modulen für sich

selbst.

- Integrationstest (Integration Testing): Testen

des schrittweisen Zusammenfügens der einzelnen Module.

- Systemtest (System Testing): Testen des Gesamtsystems unter realen Bedingungen.

- Abnahmetest

(Acceptance Testing): Ein Kunde oder ein Anwender

testet das System gegenüber der Spezifikation. Gegebenenfalls werden dabei

auch Änderungen an der Spezifikation durchgeführt.

- Regressionstest

(Regression Testing): Diese Testphase wird bei

der Weiterentwicklungen von Software verwendet. Dabei wird getestet, ob

eine neue Version einer Software die Kontrakte der Vorgängerversion noch

erfüllt.

In den einzelnen Phasen können verschiedene

Testmethoden eingesetzt werden. Dabei unterscheidet man zwischen zwei

Kategorien [1]:

Statische

Testmethoden: Tests die ohne das Ausführen des zu

testenden Programms - im Folgenden kurz als SUT (Software under test)

bezeichnet – durchgeführt werden können. Beispiele dafür sind:

Schreibtischtests, Code-Inspektionen, Walkthroughs und Checklisten.

Dynamische

Testmethoden: Diese Tests führen das Programm

tatsächlich aus. Dabei werden Ergebnisse und Parameter mit Vorgabewerten

verglichen. Dynamische Testmethoden werden wieder in zwei große Klassen

unterteilt: White-Box-Testing und Black-Box-Testing.

Das White-Box-Testing wird vor allem

verwendet, um in frühen Phasen der Entwicklung das korrekte Verhalten einzelner

Komponenten zu gewährleisten.

Abbildung

2.2: Das

White-Box-Testing-Prinzip

In Abbildung

2.2 wird das Prinzip des White-Box-Testings dargestellt.

Der Tester hat dabei die vollständige Information über die innere Struktur der

Software. Deshalb wird diese Testmethode auch als strukturelles Testen

bezeichnet. Auch die Auswahl der Testfälle wird mit Hilfe der Kenntnis der

inneren Struktur durchgeführt. Dabei haben sich drei Alternativen etabliert

[1]:

- Die Testfälle werden so ausgewählt, dass jede Anweisung

zumindest einmal ausgeführt wird.

- Die Testfälle werden so ausgewählt, dass jede Bedingung

zumindest einmal auf wahr und einmal auf falsch gesetzt ist.

- Die Testfälle werden so gewählt, dass jeder Pfad zumindest

einmal ausgeführt wird.

Wobei die Alternative drei das „stärkere“

Auswahlkriterium für Testfälle ist. Diese Alternative bedeutet, dass unter

anderem alle Schleifen bis zur maximalen Durchlaufsgrenze ausgeführt werden

müssen. Da diese Bedingung oft zu unendlich vielen Testläufen führen würde, ist

sie nicht vollständig realisierbar.

White-Box-Testing wird vor allem für das

Unit-Testing verwendet. Dabei werden die Tests meist vom Entwickler selbst

erstellt. Dieser hat Kenntnis über den zu testenden Quellcode. Das Prinzip

dabei ist, zuerst die kleinsten Einheiten mit vollständiger Kenntnis des

Quellcodes zu testen und dann kontinuierlich zu größeren Einheiten und dafür zu

weniger Kenntnis der internen Struktur überzugehen. Schließlich kennt der

Tester – nicht mehr der Entwickler selbst - nur mehr die Schnittsellen zwischen

den einzelnen Komponenten und man hat die Integrationstestphase erreicht.

Das Black-Box-Testing wird verwendet, um

die Spezifikation und die Umsetzung zu vergleichen. Dabei ist keine Kenntnis

der internen Programmstrukturen nötig [1].

Abbildung

2.3: Das

Black-Box-Testing-Prinzip

In Abbildung

2.3 wird das Prinzip des Back-Box-Testings dargestellt.

Der Tester überprüft, ob die Software die in der Spezifikation geforderten

Aufgaben richtig erfüllt. Dabei wird keine Information über die innere Struktur

der Software benötigt. Die Auswahl der Testfälle wird deshalb ausschließlich

mit Hilfe der Spezifikation durchgeführt. Aus der Spezifikation werden alle

benötigen Funktionen ermittelt und alle dafür möglichen Eingaben in

Eingabeklassen eingeteilt. Für ein Ganzzahlenfeld würden standardmäßig folgende

vier Eingabeklassen entstehen:

- Gültige Eingabe größer 0

- Gültige Eingabe gleich 0

- Gültige Eingabe kleinern 0

- Ungültige Eingabe

Theorietisch reicht es für jede der gültigen

Eingabeklassen einen Testfall für die zu testenden Funktion zu erstellen. Es

ist jedoch üblich zumindest drei Testfälle pro gültige Eingabeklasse zu

erstellen. Dabei werden meist die untere und die obere Grenze der Klasse und

ein Wert aus der Mitte der möglichen Werte genommen. Für die Klasse der

ungültigen Eingaben gilt jedoch: je mehr Testfälle desto besser [1].

Black-Box-Testing hat drei wesentliche

Vorteile gegenüber dem White-Box-Testing [1]:

- Die Tests basieren auf der Spezifikation und nicht auf der

Umsetzung. Dadurch werden Missverständnisse zwischen Spezifikation und

Programmierung erkannt.

- Die Tests bleiben großteils unabhängig von der Implementierung

und sind deshalb auch nach einer Änderung der Implementierung noch

verwendbar.

- Die Tests können sich auf die, in der Spezifikation als

wesentlich festgehaltenen, Funktionen konzentrieren.

Diesen Vorteilen stehen folgenden Nachteile

des Black-Box-Testings gegenüber:

- Black-Box-Testing kann nicht vollständig sein, weil es

normalerweise eine unendliche Menge an verschiedenen Eingaben für eine

Funktion gibt.

- Black-Box-Testing erkennt keine Implementierungsschwachstellen,

wie beispielsweise nicht erreichbaren, unnötigen Code.

- Beim Black-Box-Testing ist der Quellcode nicht bekannt, deshalb

können besonders komplexe Methoden nicht intensiver getestet werden.

- Black-Box-Testing ist erst möglich, wenn die zu testende

Funktion vollständig ausführbar ist.

Es ist bei beiden Methoden wichtig, dass

die erwarteten Testergebnisse vor der Testausführung festgelegt werden.

Manchmal können die Ergebnisse von Testfällen direkt aus der Spezifikation

beziehungsweise aus der Funktionsbeschreibung abgeleitet werden. Wenn dies

nicht möglich ist, müssen die Ergebnisse von einem Orakel, entweder einem

menschlichen Experten oder einem anderen Programm, vorhergesagt werden.

Eine andere Methode um die erwarteten

Ergebnisse vorhersagen zu können, bieten Tests, bei denen die erwarteten Ergebnisse

durch eine Vorgängerversion der SUT festgelegt werden. Diese Art des Testens

zählt zu der Kategorie der Regressionstests. Als Software-Regressionstests

werden alle Software-Tests bezeichnet, die versuchen festzustellen, ob ein

Kontrakt der Spezifikation, der in einer Vorgängerversion der SUT bereits

erfüllt war, in der aktuellen Version noch erfüllt wird. [1]

Diese Methode nutzt dabei die Eigenschaft

von Software-Produkten, dass von einer Version einer Software auf die nächste

der Großteil der Spezifikation gültig bleibt. Deshalb können die Tests und die

erwarteten Ergebnisse der Vorgängerversion übernommen werden. Im Endeffekt

müssen nur mehr die Neuentwicklungen und die Änderungen die ersten fünf zuvor

in Kapitel 2 beschriebenen Testphasen durchlaufen. Der Großteil

der Spezifikation muss lediglich die bereits existierenden Regressionstests

passieren. Mit Hilfe von Regressionstests kann also sehr viel Zeit eingespart

werden.

Regressionstests können sowohl

White-Box-Tests als auch Black-Box-Tests sein [2]. In der Regressionstestphase werden

deshalb sowohl die bereits existierenden Unit-Tests als auch die

automatisierten Abnahmetests ausgeführt.

Das in dieser Arbeit entwickelte Werkzeug Web-TEST

unterstützt die Erstellung und Wartung von Regressionstests und die automatische

Ableitung der erwarteten Ergebnisse aus einer Vorgängerversion der SUT und kombiniert diesen Testansatz mit dem

Black-Box-Testing-Prinzip. Web-TEST konzentriert sich also auf die

Wiederverwendung der Abnahmetests. Dabei

wird vor allem auf folgende Punkte geachtet, um die Vorteile von

Regressionstests und Black-Box-Testing auch wirklich an den Tester weitergeben

zu können:

- Geringe Abhängigkeit zwischen dem Quellcode der SUT und der Testdefinition.

Die Testdefinition bezieht sich ausschließlich auf die HTTP- und die

HTML-Schnittstelle der SUT.

- Einfache Generierung der Testfälle durch Aufzeichnen von

Testdefinitionen während der Benützung der SUT. Dabei werden sowohl die zu

testenden Funktionen (HTTP-Requests), die Eingaben (HTTP-Parameter), und

auch gleich die Ergebnisse (HTTP-Responses inklusive der HTML-Seiten) aufgezeichnet.

Die erwarteten Ergebnisse für spätere Versionen der SUT (Bedingungen für

die Responses) können dann mit Hilfe der aufgezeichneten Responses

generiert werden.

- Möglichkeit der Automatisierung der Testausführung nach

Fertigstellung einer neuen Version, beispielsweise über Ant-Skripts [15].

Dem Gegenüber stehen folgende Nachteile von

Web-TEST und der Regressionstests im Allgemeinen:

- Das Testen von neuen Funktionen gestaltet sich eher aufwendig

und sollte entweder mit Hilfe eines anderen Werkzeugs oder weiter manuell

durchgeführt werden.

- Weiters ist es nicht möglich neue Funktionen zu testen, bevor

sie nicht in der Benutzeroberfläche – der HTML-Schnittstelle - realisiert

sind.

- Änderungen in der Spezifikation bewirken, dass bereits

erstellte Regressionstests für neue Versionen der SUT ungültig werden und

neu erstellt oder geändert werden müssen.

Dieses Kapitel betrachtet

das Werkzeug Web-TEST aus der Sicht des Benutzers. Einleitend wird beschrieben,

wie Web-TEST installiert und konfiguriert wird. Dann wird ein umfassender Anwendungsfall

durchgespielt, der die wesentlichen Funktionen und Konzepte von Web-TEST

darstellt.

Folgende Voraussetzungen

sind für das Verständnis dieses Kapitels erforderlich:

- Erfahrung mit Eclipse [16].

- Erfahrung mit dem HTTP-Protokoll und Kenntnis

des HTTP-Request-Response-Zyklus [17].

- Grundlegende Kenntnisse über HTML [18].

- Grundlegende Kenntnisse über XML und XPath [19].

- Erfahrung mit den Testmethoden für

Webanwendungen [siehe 1 und 2] beziehungsweise Verständnis des Kapitels 2 „Methoden zum funktionalen Testen von HTML-basierten

Webanwendungen“.

Für die Installation von

Web-TEST ist eine vorhergehende Installation von Eclipse und TPTP 4.5.1 oder

höher erforderlich. Näher Details zur Installation dieser Voraussetzung findet

man unter [20]. Web-TEST steht als Eclipse-Feature

zum Download unter https://sourceforge.net/projects/tptpwebtest/

zur Verfügung. Ein Eclipse-Feature ist eine Sammlung von Eclipse-Plugins, die

nur in Kombination sinnvoll funktionieren. Das Eclipse-Feature für Web-TEST

wird als Zip-Datei heruntergeladen. Die Zip-Datei muss dann in den

Eclipse-Installationsordner entpackt werden, um die Installation fertig zu

stellen. Dabei werden ältere Versionen von Web-TEST ersetzt. Danach muss

Eclipse mit der Option „-clean“ neu gestartet werden, damit die Änderungen

übernommen werden.

Nach der Installation

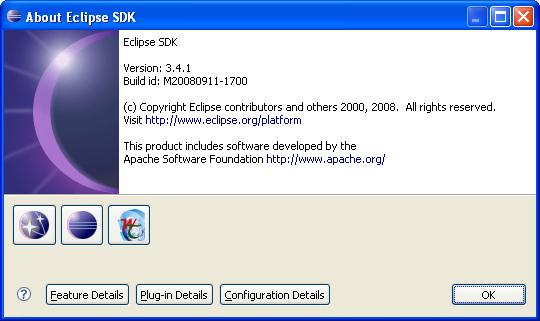

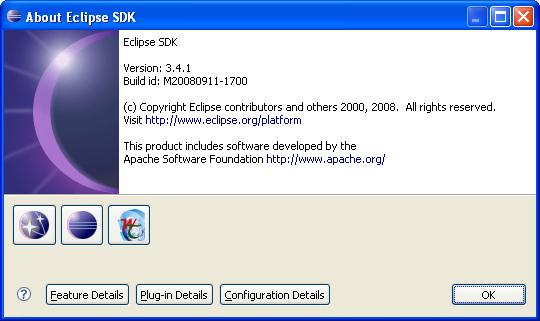

wird im About-Eclipse-SDK-Dialog, zu finden

im Menu „Help/About Eclipse SDK“, das Web-TEST-Icon ( )

angezeigt. Abbildung 3.1 zeigt diesen Dialog.

)

angezeigt. Abbildung 3.1 zeigt diesen Dialog.

Abbildung

3.1: About-Eclipse-SDK-Dialog mit Web-TEST-Icon

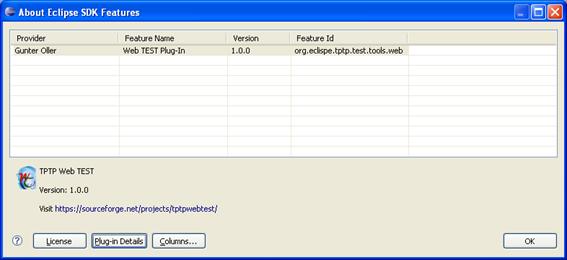

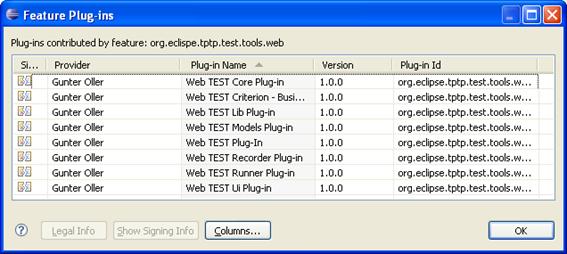

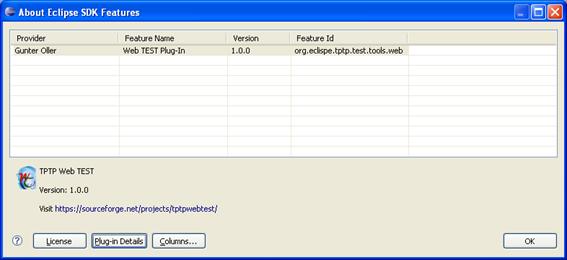

Wenn man auf das

Web-TEST-Icon klickt, bekommt man die Information, welche Eclipse-Features und

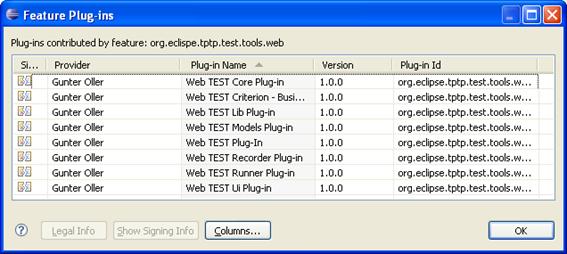

–Plug-Ins zu Web-TEST gehören und unter welcher Lizenz Web-TEST verfügbar ist. Abbildung 3.2 zeigt den Dialog, der erscheint wenn man auf das

Web-TEST-Icon klickt und Abbildung 3.3 zeigt den Dialog, der die Web-TEST-Plug-Ins

auflistet.

Abbildung

3.2:

About-Eclipse-SDK-Feature-Dialog für Web-TEST

Abbildung

3.3: Feature-Plug-Ins-Dialog

für Web-TEST

Web-TEST kann ebenfalls

über den Eclipse-Update-Manager [22]

installieren werden. Die dafür nötige Eclipse-Update-Site ist unter http://tptpwebtest.sourceforge.net/

verfügbar.

Alle Funktionen von

Web-TEST werden dem Benutzer über die Eclipse-Perspektive „Test“ zur Verfügung

gestellt. Zu finden ist diese Perspektive, ausgehend von einer englischen

Eclipse-Installation, unter dem Menu „Window/Open Perspective/Other …/Test“ ( ).

).

Bevor man

jetzt einen Test erstellen kann, müssen einige Einstellungen gesetzt werden und

ein Java-Projekt muss erzeugt werden. Diese Konfigurationen müssen nur einmal

nach der Installation von Web-TEST durchgeführt werden.

Folgende

Vorbereitungen sind notwendig:

- Testen des Agent-Controllers (eine Erklärung des

Agent-Controllers folgt)

- Konfigurieren eines Web-Browsers und eines Proxy-Ports

mit denen Tests aufgenommen werden

- Einstellen eines Inhaltsfilters

- Anlegen eines Java-Projekts

Der Agent-Controller ist ein eigener Dienst, der vom TPTP-Framework

zur Verfügung gestellt wird. Er wird von TPTP unter anderem zum Aufnehmen der

Tests verwendet. Dieser Dienst muss auf dem Rechner, auf dem der Test aufgenommen

werden soll, laufen. Deshalb muss man überprüfen, ob dieser Dienst auf diesem

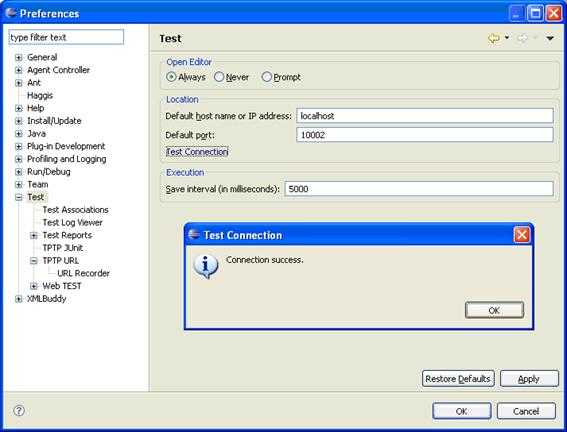

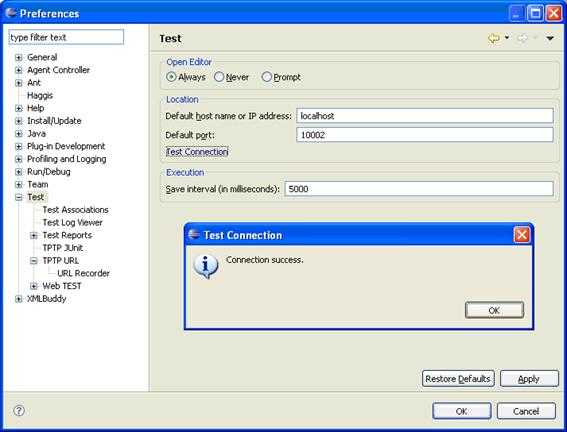

Rechner ausgeführt wird und richtig auf Anfragen reagiert. Dazu kann die

Funktion „Test Connection“ in der Eclipse-Einstellungsseite „Test“ ausgeführt

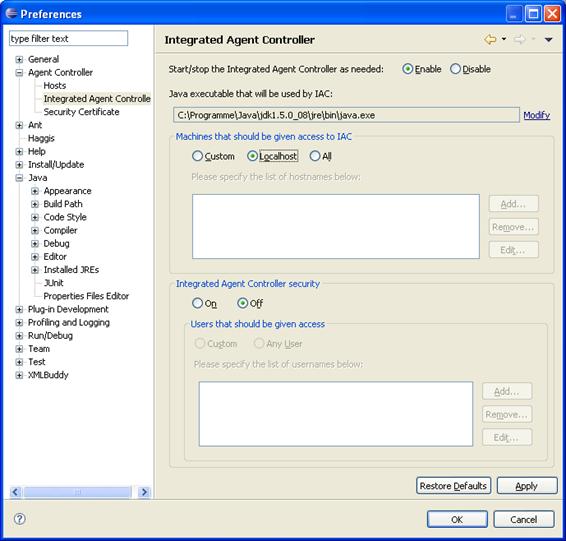

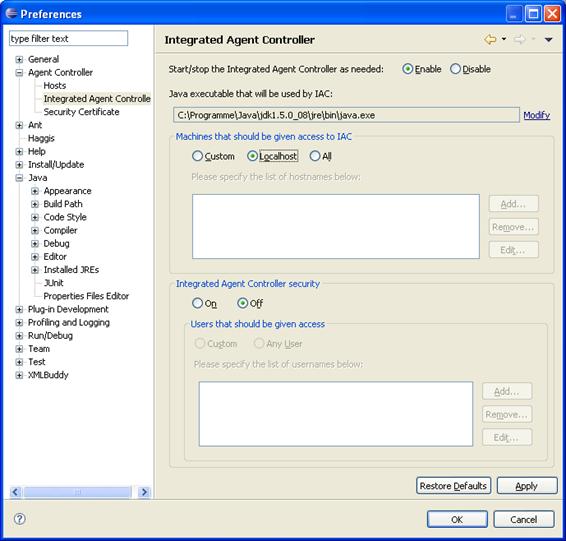

werden. Abbildung 3.4 zeigt die Eclipse-Einstellungsseite „Test“. Diese

Eclipse-Einstellungsseiten findet man unter dem Menüpunkt „Window/Preferences“.

Abbildung

3.4: Testen des Agent

Controllers

Die

Antwort, die man nach klick auf den Link bekommt, muss der Nachrichtenbox in Abbildung 3.4 entsprechen. Es muss also der Text „Connection

success.“ angezeigt werden. Im Fehlerfall lassen sich die Einstellungen für den

Agent-Controller in der Einstellungsseite „Agent

Controller/Integrated Agent Controller“ anpassen - wie in Abbildung 3.5 dargestellt.

Abbildung

3.5: Konfigurieren des Agent

Controllers

Die genaue Konfiguration

des Agent-Controllers ist Teil von TPTP und kann in der Dokumentation von TPTP

unter [13] nachgelesen werden.

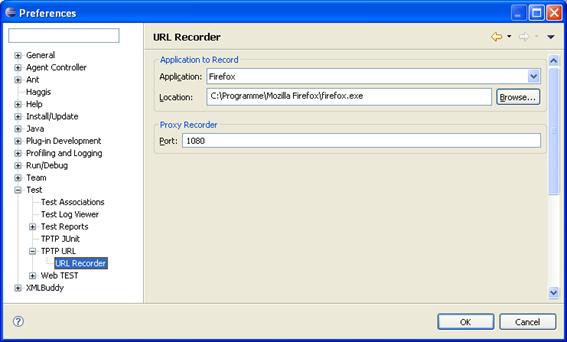

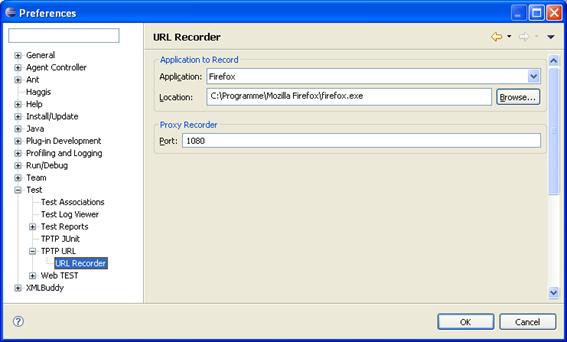

Nach dem erfolgreichen Test

des Agent-Controllers muss man Web-TEST bekannt geben welcher Browser für die

Testaufzeichnung verwendet wird.

Abbildung

3.6: Konfiguration des Browser

für die Testaufnahme

Diese Konfiguration kann

auf der Einstellungsseite „Test/TPTP URL/URL Recorder“ durchgeführt werden. Die

Abbildung 3.6 zeigt die Konfiguration des Mozilla-Firefox-Browsers

zur Aufnahme. Weiters kann hier der Port für den Proxy-Dienst eingestellt

werden. Der von TPTP vorgeschlagene Port ist 1080. Es kann jedoch jeder freie

Port für diesen Dienst verwendet werden. Der Proxy-Dienst ist Teil des Agent-Controllers

und wird zum Aufzeichnen eines Tests benötigt.

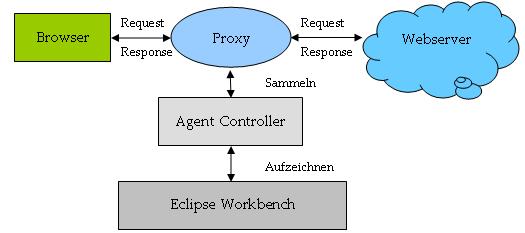

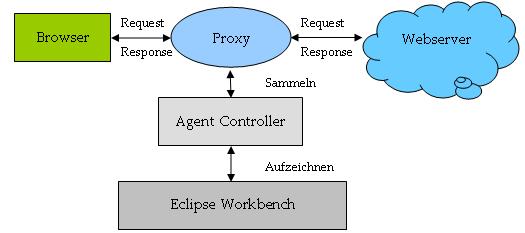

Abbildung

3.7: Der Proxy-Dienst zum

Aufzeichnen von Testdaten

Wie Abbildung 3.7 zeigt, wird der Proxy-Dienst zwischen dem Browser und

der SUT geschoben und zeichnet alle Nachrichten auf.

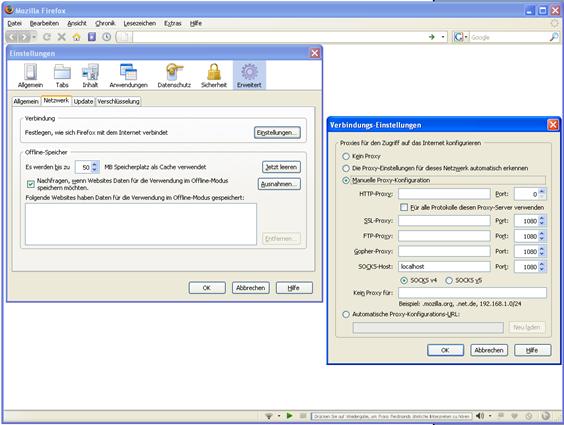

Zu beachten ist, dass es

Unterschiede in der Verwendung verschiedener Browser innerhalb von TPTP gibt.

Beispielsweise werden die Proxy-Einstellungen im Internet-Explorer automatisch

übernommen, während Firefox diese nicht übernimmt. Dafür hat der

Internet-Explorer ein Problem, wenn auf den Server „localhost“ zugegriffen

wird. In diesem Fall ignoriert er die Proxy-Einstellungen. Um dennoch eine

Anwendung auf „localhost“ aufzeichnen zu

können, kann man sich mit dem Work-around „localhost.“ (sprich:

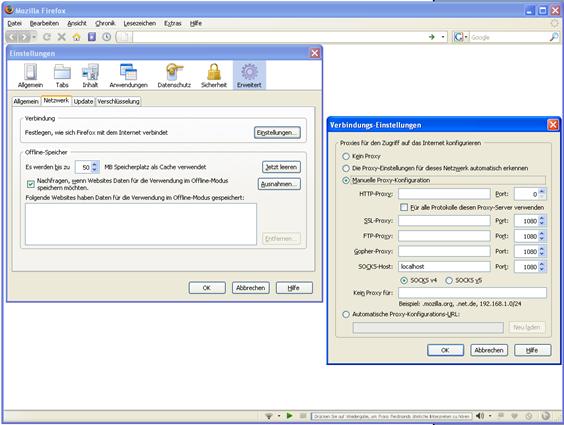

„localhost-punkt“) abhelfen. In Firefox muss der Proxy hingegen manuell

definiert werden und wird dafür auch bei „localhost“ verwendet.

Abbildung

3.8: Konfiguration des Proxies

in Mozilla Firefox

Die Proxy-Einstellungen

können in Firefox unter dem Menüpunkt

„Extras/Einstellungen…/Erweitert/Netzwerk/Einstellungen…“ festlegt werden. In Abbildung 3.8 wird dargestellt, wie der Proxy für die

Standardkonfiguration von Web-TEST eingestellt werden muss. Dabei wird ein

„SOCKS v4“-Proxy auf „localhost“ und Port „1080“ eingetragen. Um den Proxy für

andere Browser einzustellen kann die Hilfe des jeweiligen Browsers verwendet werden.

Um

unnötige Testdaten zu vermeiden kann ein Inhaltsfilter für das Generieren der

Testressource in Web-TEST definiert werden. Beispielsweise ist es aufgrund der

Eigenschaften der Assertions sinnvoll, nur HTML-Antworten zu speichern.

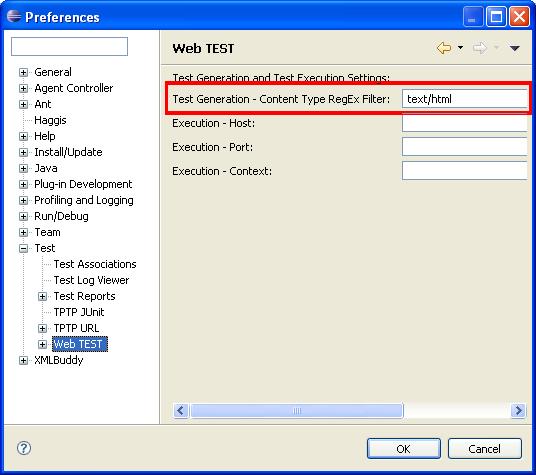

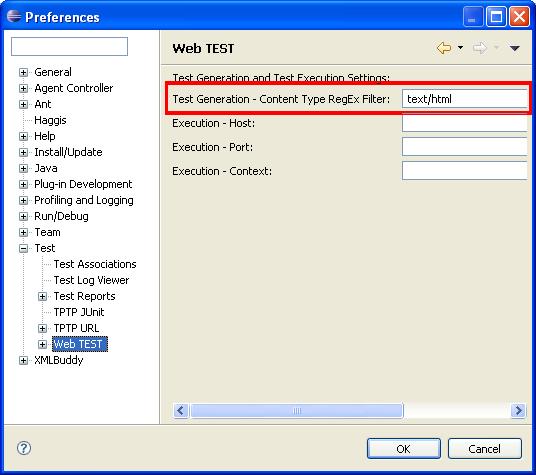

Abbildung

3.9: Content Filter

Abbildung 3.9 zeigt die Einstellungsseite „Test/Web-TEST“, in der

dieser Filter definiert wird. In diesem Beispiel ist der Filter auf „text/html“

gesetzt. Dadurch werden nur die Requests, die HTML-Seiten als Antwort haben, in

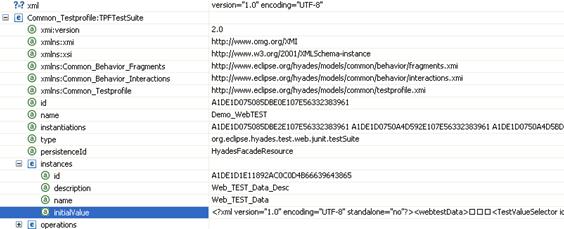

die TPTP-Testressource übernommen. Die TPTP-Testressource (oder kurz die Testressource)

ist die Ressource, die die gesammelte Testbeschreibung enthält. Diese Ressource

wird in TPTP durch eine XML-Datei realisiert.

Weiters zeigt Abbildung 3.9 drei weitere Eingabefelder: „Execution – Host“,

„Execution – Port“ und „Execution – Context“. Diese können dazu verwendet

werden, um bei der Testausführung den Host, den Port und den Kontext der

Requests zu überschreiben. Dadurch kann der Tests auf eine andere Version der

SUT (unter einer anderen URL als bei der Testaufnahme) ausgeführt werden.

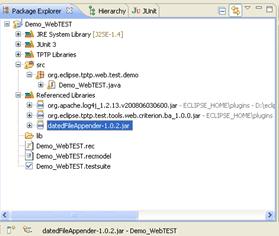

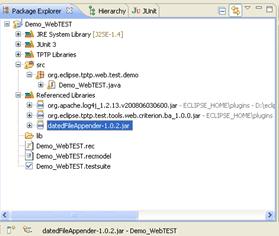

Bevor man nun beginnen kann

einen Test zu erstellen, muss man noch ein Java-Projekt anlegen. Dies ist

erforderlich, weil die Testressource später in eine JUnit-Klasse umgewandelt

wird, damit der Test ausgeführt werden kann. Für den hier folgenden

Anwendungsfall wird das Java-Projekt „Demo_WebTEST“ benannt und alle anderen

Standardeinstellungen des Java-Project-Wizards beibehalten.

Der Java-Project-Wizard ist der Eclipse-Wizard der zum Anlegen von

Java-Projekten verwendet werden kann.

Nun ist Web-TEST

installiert und vollständig konfiguriert und kann verwendet werden.

Der folgende Anwendungsfall

stellt alle wesentlichen Funktion von Web-TEST vor. Üblicherweise durchläuft

der Benutzer von Web-TEST sechs Phasen um eine HTML-basierte Webanwendung zu

testen. Diese Phasen werden im Rahmen des Anwendungsfalls in einzelnen

Unterkapiteln beschreiben:

- Aufzeichnen eines Tests.

- Bearbeiten des aufgezeichneten Tests.

- Erstellen von Bedingungen für das Ausführen

des Tests (im Folgenden als Assertions

bezeichnet).

- Bearbeiten der Assertions.

- Festlegung von dynamischen

Request-Parametern. Siehe Kapitel 3.3.5 für eine detaillierte Erklärung der dynamischen

Request-Parameter.

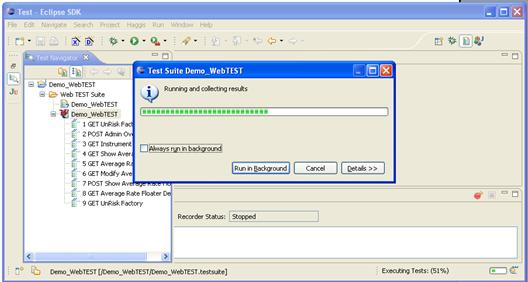

- Programmgesteuertes Abspielen des Tests (mit

einer anderen Version der SUT) und automatische Kontrolle der Ergebnisse.

Der Tester verwendet die

SUT ganz normal, um einen Test aufzuzeichnen. Während der Verwendung der SUT

läuft im Hintergrund ein Prozess, der alle Eingaben (Requests) und die darauf

folgenden Ausgaben (Responses) aufzeichnet. Web-TEST bietet zum Steuern dieses

Prozesses die Recorder-Ansicht (Recorder-Control). Diese wird in der

Eclipse-Test-Perspektive im unteren Bereich der Benutzeroberfläche dargestellt.

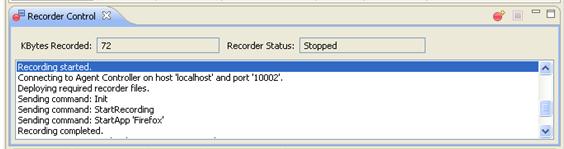

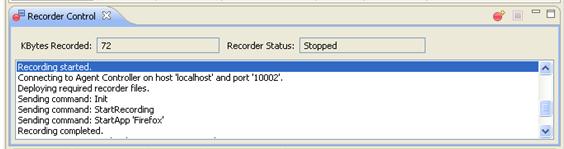

Abbildung

3.10: Die Recorder-Ansicht

Abbildung

3.10 zeigt die Recorder-Ansicht nach einer erfolgreichen

Aufnahme. Die beiden Buttons rechts oben ermöglichen es, eine Aufnahme zu

starten ( )

und zu stoppen (

)

und zu stoppen ( ).

Im Feld „KBytes Recorded“ wird die Größe der aufgenommen Daten angezeigt. Das

Feld „Recorder Status“ zeigt den aktuellen Status der Aufnahme an und im

darunter liegenden Textfeld werden detaillierte Statusnachrichten ausgegeben.

).

Im Feld „KBytes Recorded“ wird die Größe der aufgenommen Daten angezeigt. Das

Feld „Recorder Status“ zeigt den aktuellen Status der Aufnahme an und im

darunter liegenden Textfeld werden detaillierte Statusnachrichten ausgegeben.

Abbildung

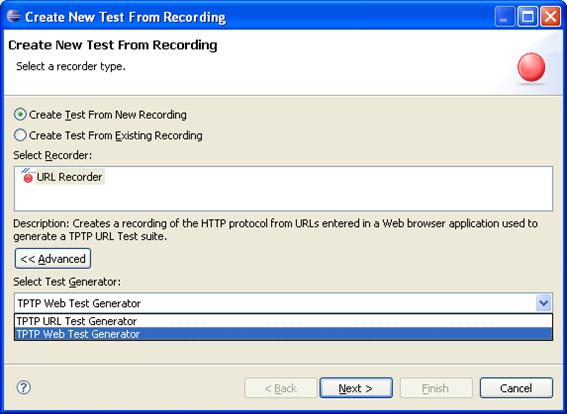

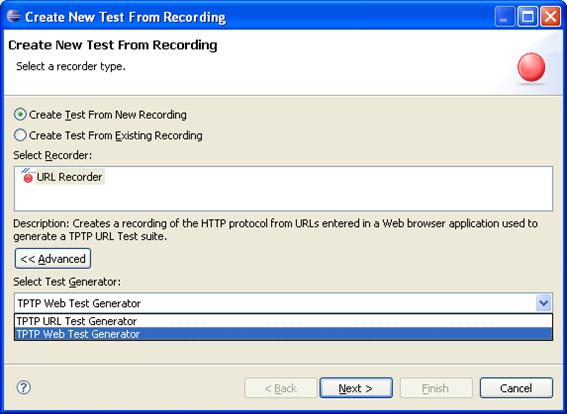

3.11: Der

Testaufzeichnungs-Wizard erste Seite

Beim Starten der Aufnahme

über den Button  der Recorder-Ansicht wird der in Abbildung 3.11 dargestellte Wizard aufgerufen. Dieser erlaubt auf der ersten Seite folgende Einstellungen:

der Recorder-Ansicht wird der in Abbildung 3.11 dargestellte Wizard aufgerufen. Dieser erlaubt auf der ersten Seite folgende Einstellungen:

- Testaufnahme: Soll der Test neu aufgenommen werden oder

soll die Testressource mit Hilfe einer bereits existierenden Recorder-Datei erzeugt werden? Der

Unterschied zwischen Recorder-Datei und Testressource wird gleich nach

dieser Aufzählung erklärt.

- Recorder: Welcher Aufnahmedienst soll verwendet

werden?

- Test-Generator: Welcher Test-Generator soll verwendet werden

um eine TPTP-Testressource zu erstellen?

Der Recorder speichert die

gesamte Kommunikation zwischen Browser und Web-Server(n) in einer

Recording-Datei. Eine Recorder-Datei enthält alle aufgenommenen Nachrichten,

und aus ihr kann die Testressource generiert werden. Nach der Testaufnahme

stehen also zwei Dateien zur Verfügung: die Recorder-Datei mit allen Nachrichten

in einem speziellen Trace-Datenschema [35], das in TPTP Standard ist für

jegliche Test- und Messdatenaufzeichnung, und die daraus abgeleitete

Testressource. Der Test-Generator ist für die Generierung der Testressource aus

der Recorder-Datei verantwortlich.

Für diesen Anwendungsfall

müssen, wie in Abbildung 3.11 dargestellt, folgende Einstellungen gewählt werden:

- Testaufnahme = „Create Test

From New Recording“.

- Recorder = „URL Recorder“.

- Test Generator = „TPTP Web TEST

Generator“

Der von Web-TEST

angebotene „TPTP Web TEST Generator“ hat den Vorteil, dass er auch die

Antworten der Web-Servers, also die HTTP-Responses (im Folgenden kurz als

Response bezeichnet), behandelt und sie in die erstellte Testressource einbaut.

Der „TPTP URL Test Generator“ zeichnet hingegen keine Responses auf.

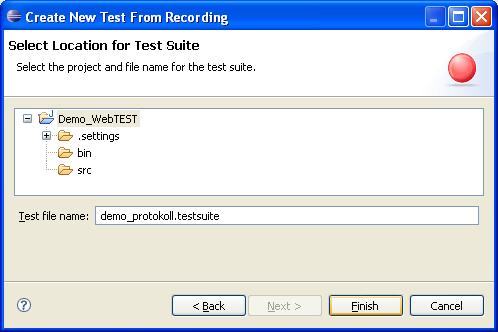

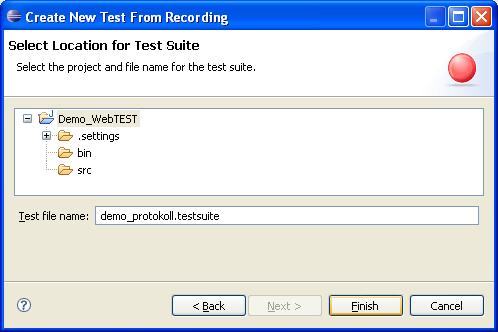

Abbildung

3.12: Der

Testaufzeichnungs-Wizard zweite Seite

Als nächstes wird man

nach einem Speicherort und einem Namen für die Testressource gefragt. Abbildung 3.12 stellt diesen Dialog dar. Nachdem man beides

ausgewählt hat, kann man mit dem Button „Finish“ den Wizard beenden und die

Testaufzeichnung wird gestartet. Dabei wird der zuvor eingestellte Browser

automatisch gestartet. Dieser darf jedoch vorher noch nicht ausgeführt werden.

Nun kann der Test in der SUT durchgespielt werden. Abbildung

3.13 veranschaulicht die Testaufzeichnung für dieses

Szenario. Der Benutzer verwendet dabei die SUT wie üblich, während der Recorder

im Hintergrund alle Anfragen (Requests) und Antworten (Responses) aufzeichnet.

Abbildung

3.13: Verwendung der SUT während

der Testaufzeichnung

Für dieses Szenario wurde die Anwendung UnRisk-FACTORY in der

Version 1.2.12 (siehe [2]) verwendet. Die im nächsten Teil dieses Kapitels

verwendete Aufnahme kann wie folgt nachgestellt werden:

- Aufruf der Seite

http://www.unrisk.com/unriskfactory/pages/admin/overview.do

im Browser

- Login mit Benutzername „oeller“ und Passwort

„oeller“.

- Klicken des Links „Instruments“ im

horizontalen Menu oben.

- Klicken des Links „IR Types/Average Rate

Floaters“ im vertikalen Menu links.

- Danach erscheint eine Tabelle im zentralen

Bereich. In der Zeile, in der die Spalte „Name“ den Wert „Test WebTEST1“

enthält, muss rechts auf den „Details“-Link geklickt werden.

- Dann wird eine zweispaltige Tabelle

angezeigt, die alle Eigenschaften des ausgewählten Objekts darstellt.

- Klicken des Links „Edit“ rechts oberhalb der

Tabelle.

- Nun erscheint wieder eine Tabelle, die es

erlaubt, die Eigenschaften des Objekts zu ändern.

- Ändern des Felds ISIN auf „Test WebTEST_1“

anstelle von „Test WebTEST1“.

- Die Änderungen durch betätigen des Buttons

„Save Changes“ bestätigen.

- Jetzt erscheint wieder die erste Tabelle, und

man muss wieder auf den „Details“-Link in der Zeile „Test WebTEST1“

klicken.

- Daraufhin erscheinen wieder alle

Eigenschaften des Objekts. Die Eigenschaft „ISIN“ muss den neuen Wert

„Test WebTEST_1“ haben.

- Zuletzt noch über den Link „Logout“, äußerst

rechts oben, ausloggen.

Sobald man fertig ist mit

dem Durchspielen des Tests, kann man den Browser schließen. TPTP erkennt dann

je nach Browser entweder automatisch, dass der Test beendet wurde, oder man

muss noch den Stopp-Button ( )

der Recorder-Ansicht betätigen. Danach wird der gewählte Test-Generator

gestartet. Dieser generiert, aus den vom Proxy-Dienst aufgenommen Daten, die Testressource

und öffnet den Web-TEST Assertion-Editor, wie in Abbildung 3.14 dargestellten.

)

der Recorder-Ansicht betätigen. Danach wird der gewählte Test-Generator

gestartet. Dieser generiert, aus den vom Proxy-Dienst aufgenommen Daten, die Testressource

und öffnet den Web-TEST Assertion-Editor, wie in Abbildung 3.14 dargestellten.

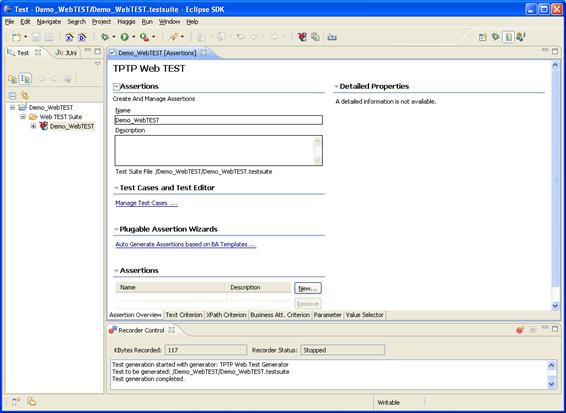

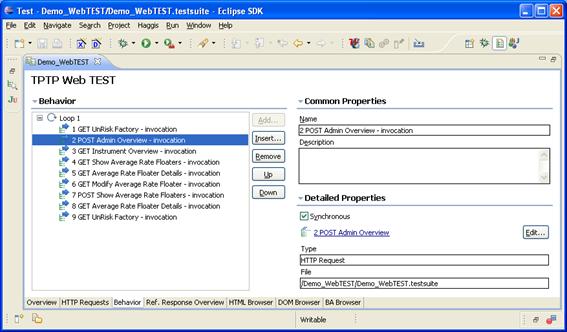

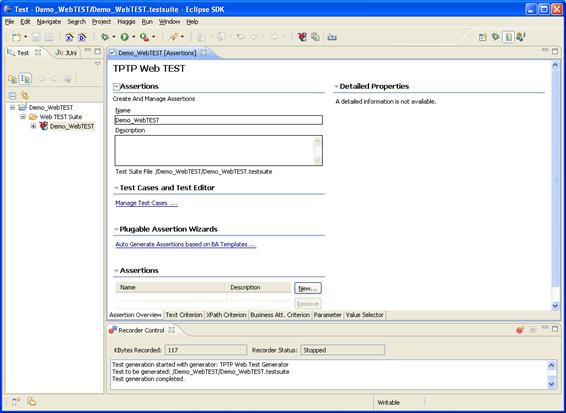

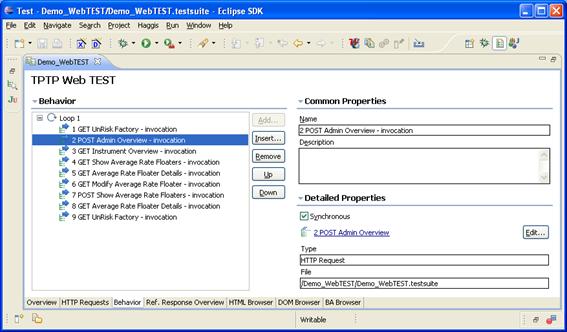

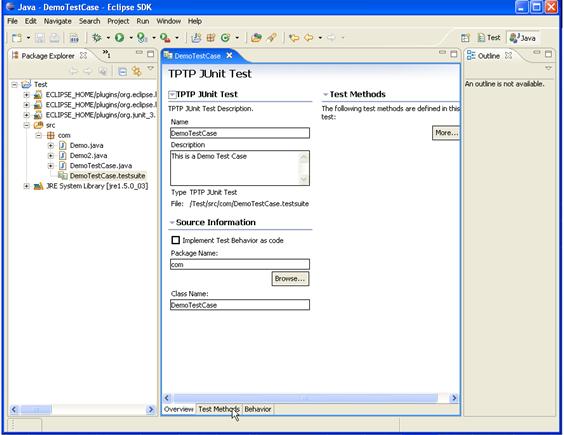

Abbildung 3.14: Der Assertion-Editor

In Abbildung 3.14 ist durch die leere Tabelle im linken unteren

Teil der Editor-Seite erkennbar, dass für die erstellte Testressource noch

keine Assertions generiert wurden. Der Assertion-Editor ist ein Multi-Page-Editor und bietet weitere

Seiten an, um Assertions zu erstellen und zu bearbeiten. Zusätzlich zu den

Funktionen zum Bearbeiten von Assertions, die im Kapitel 3.3.4 näher behandelt werden, bietet der Assertion-Editor

folgende drei Editor-Actions (Buttons

die in Eclipse speziell für einen Editor-Typ oberhalb des Editor-Fenster

angezeigt werden – siehe auch Abbildung

3.14) an:

- Change-Web-TEST-Editor (

):

Diese Aktion erlaubt es zwischen dem Web-TEST-Test-Editor zum Verwalten

der Testdefinition und dem Web-TEST-Assertion-Editor zum Verwalten der

Assertions zu wechseln.

):

Diese Aktion erlaubt es zwischen dem Web-TEST-Test-Editor zum Verwalten

der Testdefinition und dem Web-TEST-Assertion-Editor zum Verwalten der

Assertions zu wechseln.

- Generate-JUnit-Code (

):

Mit Hilfe dieses Buttons kann aus der aktuellen Testressource Java-Code generiert

werden. Der Java-Code ist später zum Ausführen des Tests erforderlich. In

Web-TEST Version 1.0 wird aus jeder Testressource eine eigene Java-Klasse

erzeugt, weil dies dem Standardschema in TPTP entspricht. Für eine spätere

Version von Web-TEST ist geplant, dieses

Java-Code-Klasse-pro-Testressource-Verfahren durch eine

Ausführungsmaschine zu ersetzten, die die Testdefinition direkt

interpretiert, ohne vorher Code erzeugen zu müssen.

):

Mit Hilfe dieses Buttons kann aus der aktuellen Testressource Java-Code generiert

werden. Der Java-Code ist später zum Ausführen des Tests erforderlich. In

Web-TEST Version 1.0 wird aus jeder Testressource eine eigene Java-Klasse

erzeugt, weil dies dem Standardschema in TPTP entspricht. Für eine spätere

Version von Web-TEST ist geplant, dieses

Java-Code-Klasse-pro-Testressource-Verfahren durch eine

Ausführungsmaschine zu ersetzten, die die Testdefinition direkt

interpretiert, ohne vorher Code erzeugen zu müssen.

- BA-Assertion-Generation-Wizard (

):

Die Abkürzung BA steht für Business Attribute, und wird in der

Oberfläche von Web-TEST verwendet, um zu lange Labelnamen zu vermeiden. Um

diese Arbeit möglichst konsistent mit der Oberfläche von Web-TEST zu

halten, wird auch hier diese Abkürzung verwendet. Die Aktion „BA-Assertion-Generation-Wizard“

startet einen Wizard, der eine automatische Generierung von Assertions

anhand vordefinierter Templates und den aufgenommenen Responses erlaubt.

Eine detaillierte Erklärung des Wizards erfolgt im Rahmen des Kapitels 3.3.3 „Erstellen von Assertions“.

):

Die Abkürzung BA steht für Business Attribute, und wird in der

Oberfläche von Web-TEST verwendet, um zu lange Labelnamen zu vermeiden. Um

diese Arbeit möglichst konsistent mit der Oberfläche von Web-TEST zu

halten, wird auch hier diese Abkürzung verwendet. Die Aktion „BA-Assertion-Generation-Wizard“

startet einen Wizard, der eine automatische Generierung von Assertions

anhand vordefinierter Templates und den aufgenommenen Responses erlaubt.

Eine detaillierte Erklärung des Wizards erfolgt im Rahmen des Kapitels 3.3.3 „Erstellen von Assertions“.

Diese Aktionen stehen im

Werkzeugmenu rechts oberhalb des Assertion-Editors als Buttons zur Verfügung

(siehe Abbildung 3.14). Die Buttons sind nur aktiv, falls ein

Web-TEST-Editor den Fokus besitzt.

Mit Hilfe der

Change-Web-TEST-Editor-Aktion des Assertion-Editors kann auf den Test-Editor

gewechselt werden. Dort kann man sich die vom Recorder erstellte Testressource

ansehen und sie bearbeiten.

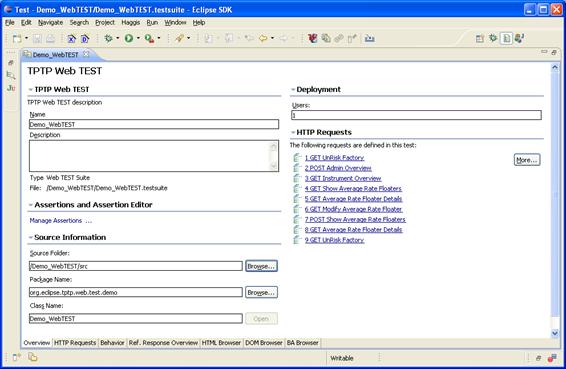

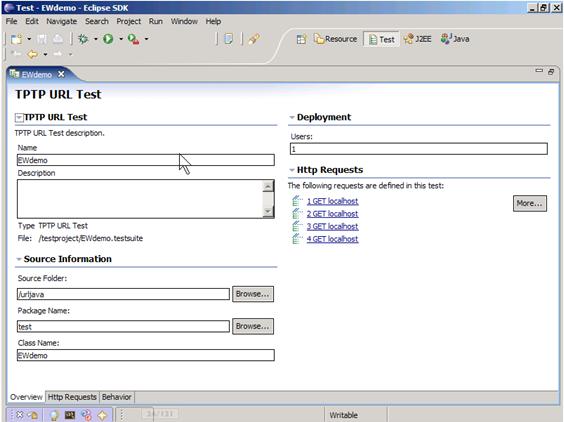

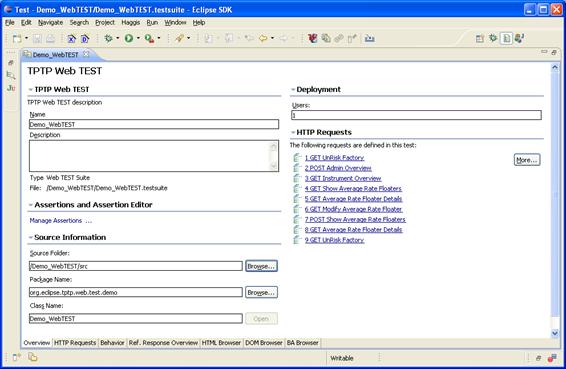

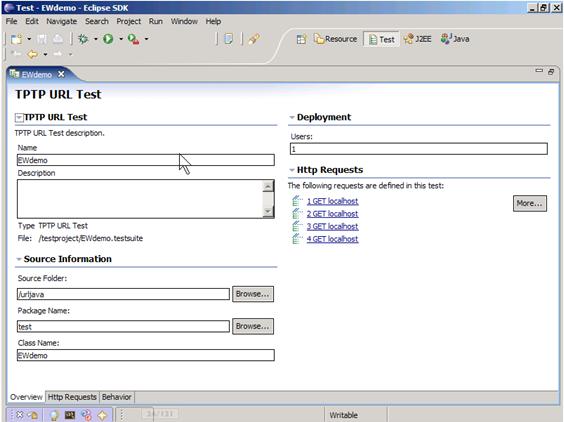

Testressource-Übersicht und

Java-Code-Verzeichnis bearbeiten

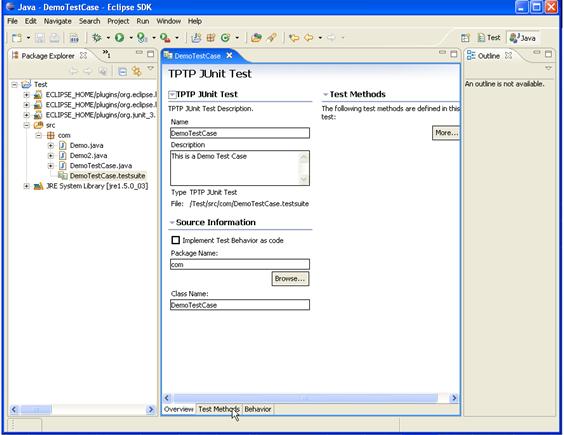

Abbildung 3.15:

Die Overview-Seite des Test-Editors

Man wird dabei auf die

„Overview“-Seite des Test-Editors geleitet. Hier sieht man einen Überblick der

aufgenommenen Requests. Abbildung

3.15 zeigt, dass neun Requests trotz Inhaltsfilter in die Testressource

übernommen wurden. Diese Requests sind rechts unter der Überschrift „HTTP

Requests“ zu sehen. Die Namen der Requests werden aus einer fortlaufenden

Nummer, der Art des Requests (GET oder POST) und dem Titel der darin enthaltenen

HTML-Seite zusammengesetzt. Weiters bietet die „Overview“-Seite die Möglichkeit

festzulegen wo der später zu generierende Java-Quellcode gespeichert wird. Dazu

kann man unter „Source Folder“ den Quellcodeordner des Java-Projekts, unter

„Package Name“ den Paket-Namen und unter „Class Name“ den Klassennamen angeben.

In diesem Szenario werden, wie in Abbildung

3.15 dargestellt, die Werte „Demo_WebTEST/src“,

„org.eclipse.tptp.web.test.demo“ und „Demo_WebTEST“ verwendet. Um gegebenenfalls

den Java-Code zu generieren, wird im Test-Editor die Generate-JUnit-Code-Aktion

( )

angeboten. Das Erstellen des Java-Codes wird in diesem Anwendungsfall erst durchgeführt,

nachdem alle nötigen Änderungen in der Testressource gemacht wurden. Beschrieben

wird das Erzeugen des Java-Codes deshalb im Kapitel 3.3.6 „Abspielen

des Tests und Kontrolle der Ergebnisse“.

)

angeboten. Das Erstellen des Java-Codes wird in diesem Anwendungsfall erst durchgeführt,

nachdem alle nötigen Änderungen in der Testressource gemacht wurden. Beschrieben

wird das Erzeugen des Java-Codes deshalb im Kapitel 3.3.6 „Abspielen

des Tests und Kontrolle der Ergebnisse“.

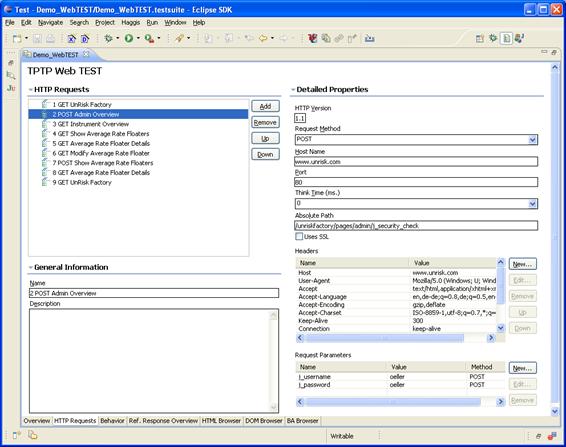

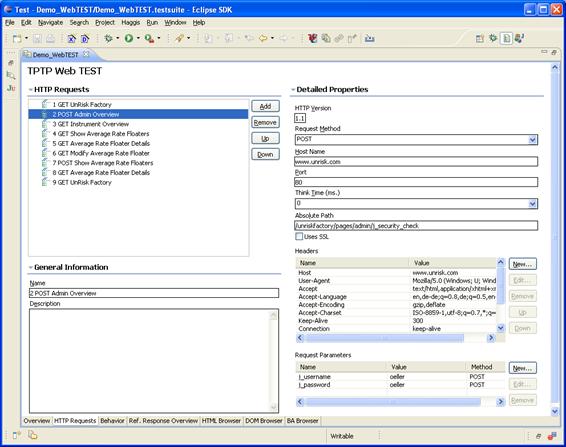

Bearbeiten der Requests

Abbildung 3.16: Test-Editor-HTTP-Requests-Seite

Die zweite Seite des Test-Editors,

die „HTTP Requests“-Seite, bietet die

Übersicht und Detailansicht aller aufgenommenen Requests. Abbildung 3.16 zeigt links oben nochmals die neun aufgenommen

Request. Diese können hier gelöscht, umgereiht oder neue hinzugefügt werden.

Die Details des markierten und damit aktiven Requests, hier der Request „2 POST

Admin Overview“, werden links unten unter „General Information“ und rechts

unter „Detailled Porperties“ dargestellt. Dabei folgende Eigenschaften des

aktiven Requests angezeigt und können editiert werden:

- Name (Name)

- Beschreibung (Description)

- HTTP-Protokoll-Version (HTTP Version) – Diese

Eigenschaft kann nicht geändert werden.

- Host-Name (Host Name)

- Port (Port)

- Wartezeit (Think Time)

- Absoluter Pfad (Absolute Path)

- Verwendung von Secure-Socket-Layer (Uses SSL) – Wird von Web-TEST noch nicht

interpretiert.

- Die Request-Header (Headers)

- Die Request-Parameter (Request Parameters)

Festlegen der Ausführungsreihenfolge der

Requests

Wichtig ist hier

anzumerken, dass die Reihenfolge der definierten Requests noch keine Auswirkung

auf die Reihenfolge während der Testausführung hat. Die Ausführungsreihenfolge

wird auf der Seite „Behavior“ des Test-Editors festgelegt (siehe Abbildung 3.17).

Abbildung 3.17:

Test-Editor-Behavior-Seite

Als Standardreihenfolge

wird die gleiche Reihenfolge verwendet, die auch aufgezeichnet wurde. In Abbildung 3.17 wird die Standardreihenfolge für diesen Anwendungsfall

dargestellt. Es ist mit Hilfe der „Behavior“-Seite möglich, Requests

umzureihen, Requests mehrmals zu verwenden oder gar nicht. Weiters können über

den Button „Insert…“ Schleifen (Loops) definiert werden, um einen oder mehrere Requests

vielfach auszuführen. Eine Schleife ist dabei ein spezieller Knoten im Baum der

selber wieder Kinder haben darf.

Bearbeiten eines Responses

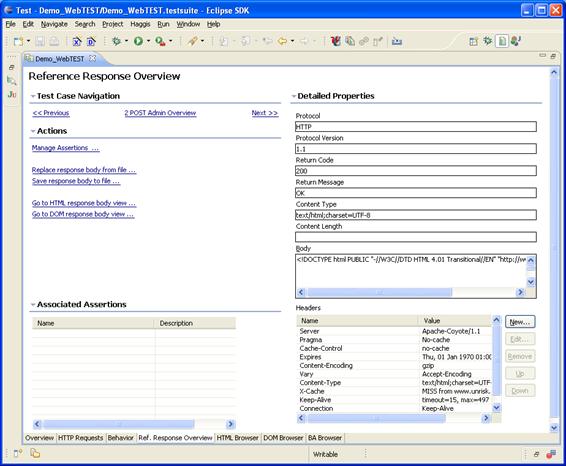

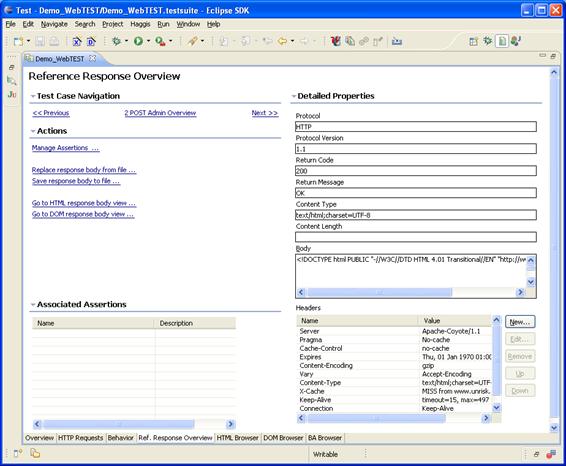

Die nächste Seite „Ref.

Response Overview“ zeigt den Response des aktiven Request. Der aktive Request

ist der Request der auf der Seite „HTTP Requests“ ausgewählt ist. Es gibt

jedoch unter dem Punkt „Test Case Navigation“, die Möglichkeit die Auswahl des

aktiven Requests zu ändern. In Abbildung

3.18 ist die „Ref. Response Overview“-Seite dargestellt

und der Punkt „Test Case Navigation“ findet sich links oben. Auch in den Seiten

„HTML Browser“, „DOM Browser“ und „BA Browser“ des Test-Editors findet man die

„Test Case Navigation“-Komponente. Jede dieser Seiten des Test-Editors stellt

den aktiven Response auf eine spezielle Weise dar.

Abbildung 3.18: Test-Editor-Ref.-Response-Overview-Seite

Die „Ref. Response

Overview“-Seite erlaubt es weiters, die Eigenschaften eines Responses zu

betrachten, zu ändern und den Inhalt des aktiven Responses über die Aktion „Replace

response body from file...“ zu ersetzten. Die angezeigten Eigenschaften des

Responses sind:

- Protokoll (Protocol)

- Protokoll Version (Protocol Version)

- Status Code (Return Code)

- Status Nachricht (Return Message)

- Typ des Inhalts (Content Type)

- Länge des Inhalts (Content Length)

- Decodierter Ausschnitt aus dem Inhalt (Body)

- Response-Header (Headers)

Weiters wird links unter

der Überschrift „Associated Assertions“ eine Übersicht von Assertions

angezeigt. Diese Assertions beziehen sich auf den dargestellten Response.

Zurzeit wurde noch keine Assertion für diesen Response erstellt, deshalb wird

in Abbildung 3.18 noch kein Eintrag angezeigt.

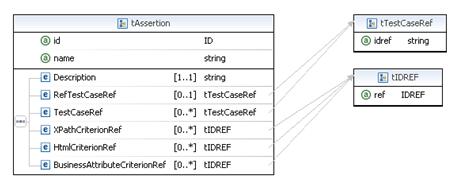

Assertions lassen sich

auf benutzerfreundliche Weise mit Hilfe der übrigen Seiten des Test-Editors

erzeugen. Bevor dieser Anwendungsfall sich mit dem Erstellen von Assertions

beschäftigt, muss zuerst der Aufbau einer Assertion erklärt werden. Eine

Assertion ist ein Container, der Kriterien enthält. Die Kriterien enthalten

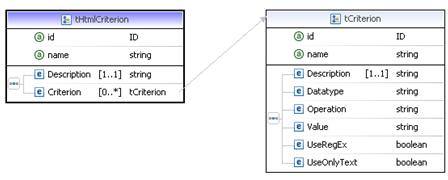

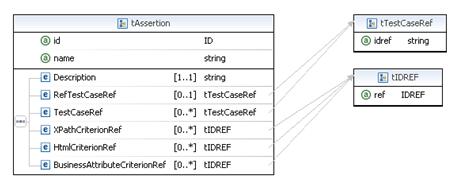

wiederum Basiskriterien. Abbildung 3.19 zeigt den Aufbau von Assertions und verwendet dazu

die in der Web-TEST-Oberfläche verwendete Benennung der Elemente.

Abbildung

3.19: Der hierarchische Aufbau

von Assertions

Basiskriterium (Basic Criterion)

Das Basiskriterium ist

die kleinste Einheit und wird durch einen Namen, einem Wert und einem

Vergleichsoperator definiert. Ein Basiskriterium enthält im Wesentlichen den

Wert nach dem gesucht wird. Je nach Typ des einschließenden Kriteriums wird

dieser Wert in einem anderen Teil des Responses gesucht. Beispiel für ein

Basiskriterium: Name=“HTML-Seiten-Titel“, Wert=“Administration“ und

Vergleichoperator=“Equals“.

Kriterium (Criterion)

Ein Kriterium ist eine

Zusammenstellung von ein oder mehreren Basiskriterien und zusätzlichen Eigenschaften.

Die zusätzlichen Eigenschaften gelten für alle enthaltenen Basiskriterien. Kein

Basiskriterium eines Kriteriums darf fehlschlagen, damit das Kriterium erfüllt

ist.

Mit Hilfe von

verschiedenen Kriterientypen ist es möglich einen Response auf verschiedene

Arten zu untersuchen. In der aktuellen Version von Web-TEST werden drei Arten von Kriterien unterstütz:

- Text-Kriterium

(Text-Criterion): Überprüft

das Vorkommen eines oder mehrerer Texte in der gesamten HTML-Seite.

Beispielsweise kann man so überprüfen, ob ein bestimmter Text wie „Error“

irgendwo in der HTML-Seite vorkommt.

- XPath-Kriterium

(XPath-Criterion): Überprüft

den Wert eines XPath-Ausdrucks. Mit dieser Art von Kriterium kann man

beispielsweise überprüfen, ob der Titel eine HTML-Seite einen bestimmten

Wert hat.

- BA-Kriterium

(Business-Attribute-Criterion): Testet die Werte von Elementen,

die zu einem bestimmten Musters

passen. Mit diesem Kriterium kann man beispielsweise alle angezeigten

Eigenschaften eines Geschäftsfeld-Objekts (Business-Objekts) der SUT, wie

sie etwa in Abbildung 1.2 für UnRisk FACTORY dargestellt sind, überprüfen.

Die Details der einzelnen

Kriterientypen werden im Kapitel 3.3.4 „Bearbeiten

der Assertions“ erklärt.

Assertion

Eine Assertion ist die

Beschreibung, wann welche Kriterien überprüft werden müssen. Dazu können einer

Assertion, wie in Abbildung 3.19 dargestellt, eine Menge von Kriterien zugeteilt

werden und außerdem können zu testende Funktionen, also Requests, zugeteilt.

Falls nun ein zugeteilter Request während einer Testausführung abgespielt wird,

dann wird die Assertion aktiviert und alle darin enthaltenen Kriterien werden

mit dem folgendem Response verglichen. Eine Assertion kann aus 0 bis n

Kriterien und 0 bis n zugeteilten Requests bestehen, wobei n theoretisch

unbegrenzt ist. Wenn eine Assertion ausschließlich Kriterien eines

Kriterientyps enthält, dann wird diese Assertion im Folgenden nach diesem Typ benannt.

Als Beispiel: eine Assertion die nur Text-Kriterien enthält, wird auch als Text-Assertion bezeichnet.

Erstellen von Text-Assertions

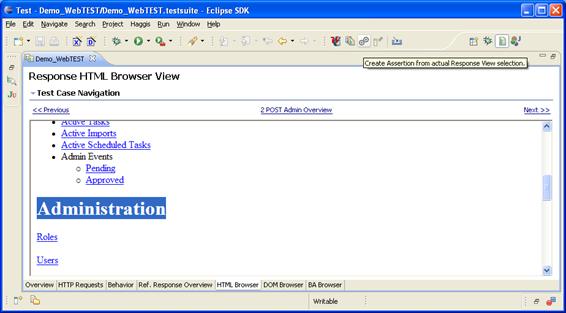

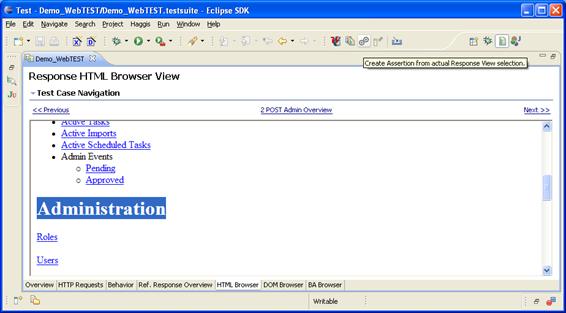

Um eine Text-Assertion

erstellen zu können, wechselt man auf die Seite „HTML Browser“ des

Test-Editors. Hier wird der aktive Response in einem HTML-Browser dargestellt.

Da der Browser nicht mit der SUT verbunden ist, sondern auf einer lokalen Kopie

des Responses arbeitet, können Bilder- und Stylesheet-Dateien nicht geladen

werden.

Abbildung 3.20: Die HTML-Browser-Seite des Test-Editors

Wie in Abbildung 3.20 dargestellt, kann Text direkt im Browser markiert

werden. Der markierte Text kann dann verwendet werden, um für den aktiven

Request eine Assertion zu erstellen. Dazu bietet der Test-Editor die Aktion

Create-Assertion ( ).

Abbildung 3.20 zeigt diese Aktion direkt neben der

Generate-JUnit-Code-Aktion (

).

Abbildung 3.20 zeigt diese Aktion direkt neben der

Generate-JUnit-Code-Aktion ( ) rechts oberhalb des Test-Editors an.

) rechts oberhalb des Test-Editors an.

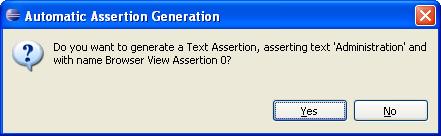

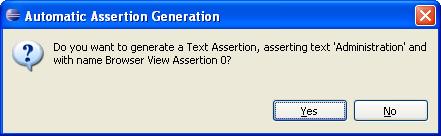

Abbildung

3.21: Der

Automatic-Assertion-Generation-Dialog für eine Text-Assertion

Nach betätigen der

Create-Assertion-Aktion ( ) erscheint ein Informationsdialog, wie er in Abbildung 3.10 dargestellt ist. Dieser Dialog zeigt noch einmal die

Eigenschaften der zu erstellenden Assertion. Dabei werden folgende

Informationen geliefert:

) erscheint ein Informationsdialog, wie er in Abbildung 3.10 dargestellt ist. Dieser Dialog zeigt noch einmal die

Eigenschaften der zu erstellenden Assertion. Dabei werden folgende

Informationen geliefert:

- Art des verwendeten Kriteriums: „Text“

- Wert der Bedingung in einfachen

Anführungszeichen: „Administration“

- Name der neuen Assertion: „Browser View

Assertion 0“

In diesem Beispiel wird

also ein Text-Kriterium mit genau einem Basiskriterium erzeugt. Das

Basiskriterium wird auf den Wert „Administration“ gesetzt. Das Text-Kriterium

wird einer neuen Assertion mit dem Namen „Browser View Assertion 0“ zugeteilt.

Weiters wird der aktive Request mit dieser Assertion verknüpft. Abbildung 3.22 zeigt nochmals grafisch den Aufbau der Assertion

„Browser View Assertion 0“.

Abbildung

3.22: Aufbau der Assertion "Browser View Assertion 0"

Diese Assertion sucht bei

der Testausführung in der HTML-Seite des Responses (des Requests) „2 POST Admin

Overview“ den Text „Administration“. Wird dieser Text irgendwo in der

HTML-Seite gefunden, dann ist die Assertion erfolgreich.

Um diese Assertion

automatisch erstellen zu lassen, muss man nur den angezeigten Dialog bestätigt.

Wenn man anschließend wieder auf die Seite „Ref. Response Overview“ zurück geht,

erkennt man das in der Tabelle „Associated Assertions“ die Assertion „Browser

View Assertion 0“ eingetragen ist.

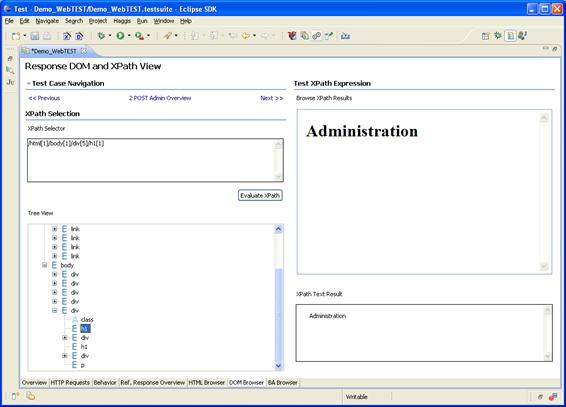

Erstellen von XPath-Assertions

Um eine Assertion für den

Wert eines bestimmten XPath-Ausdrucks zu erstellen, wechselt man auf die Seite

„DOM Browser“. Hier kann man Assertion erstellen die beispielsweise überprüfen,

ob ein bestimmte Überschrift in einer HTML-Seite einen bestimmten Wert hat.

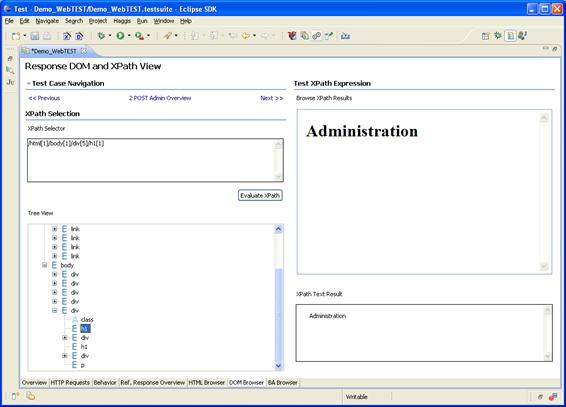

Abbildung 3.23: Die DOM-Browser-Seite des

Test-Editors

In Abbildung 3.23 wurde mittels Auswahl aus dem DOM-Baum ein

bestimmtes Element ausgewählt und der XPath-Ausdruck automatisch dafür

generiert. Es ist genauso möglich einen XPath-Ausdruck anzugeben und daraus die

Selektion im Baum zu generieren. Auf der rechten Seite wird dann in einem

Browser und zusätzlich in einem Textfeld das Ergebnis der Ausführung des

XPath-Ausdrucks im Response angezeigt. Auch für XPath-Assertions steht wieder

die Create-Assertion-Aktion ( ) zur Verfügung.

) zur Verfügung.

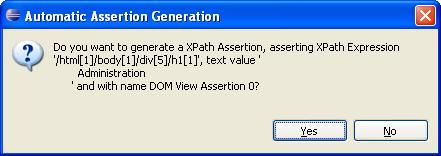

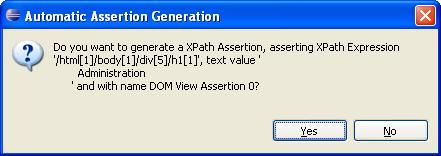

Abbildung

3.24: Der Automatic-Assertion-Generation-Dialog

für eine XPath-Assertion

Wie Abbildung

3.24 darstellt, erstellt diese Aktion, wenn sie aus der „DOM Browser“-Seite aufgerufen wird, eine XPath-Assertion. Diese Assertion überprüft bei der Ausführung,

ob im Response der XPath-Ausdruck „/html[1]/body[1]/div[5]/h1[1]“ ausgewertet werden kann und dabei der Wert

„\r\n\tAdministartion\r\n\t“ geliefert wird. Wie man erkennen kann, sind mit

Hilfe dieses Kriterientyps bereits deutlich restriktivere Bedingungen möglich.

Erstens muss das Element „/html[1]/body[1]/div[5]/h1[1]“ im DOM-Baum existieren und zweitens muss genau dieses Element den

gesuchten Wert enthalten.

Wenn man nun den in Abbildung 3.24 dargestellten Dialog bestätigt und dann wieder auf

die Seite „Ref. Response Overview“ wechselt, sieht man das jetzt zwei

Assertions dem aktiven Request zugeordnet sind.

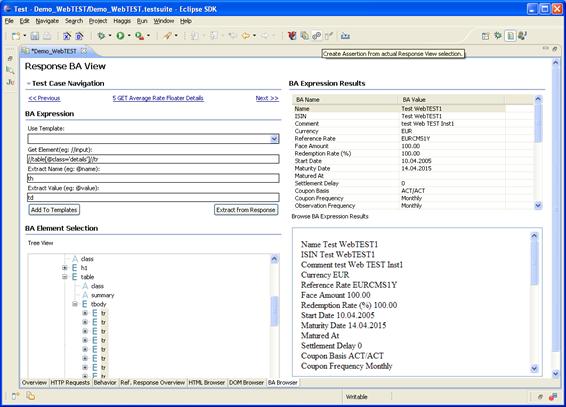

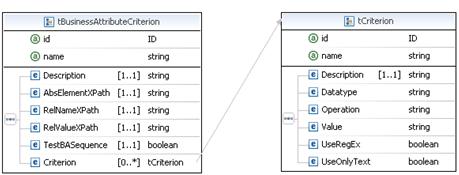

Erstellen von BA-Assertions

Die dritte Art von Kriterien dient dazu, zu

testen, ob eine Anzahl von Attributen beziehungsweise Elementen mit richtigem Namen

und Wert auf einer HTML-Seite vorkommen. Beim Erstellen eines BA-Kriteriums

wird versucht, aus der HTML-Seite eines aufgezeichneten Responses eine Liste

von Elementen zu extrahieren. Ein Element kann dabei alles sein, das einen

Namen und einen Wert besitzt und Name und Wert mittels eines bestimmten Muster gefunden

werden. BA-Kriterien verwenden zum Extrahieren der Elemente, ihrer Namen und ihrer

Werte aus dem Response XPath-Ausdrücke. Im Gegensatz zum XPath-Kriterium werden

allerdings für ein BA-Kriterium drei XPath-Ausdrücke benötigt.

- Der XPath-Ausdruck

für das Element (Get Element): Dieser Ausdruck

wählt aus dem Response alle zu betrachtenden Elemente aus. Wie schon zuvor

erwähnt wird das Element noch in einen Namen und einem Wert zerlegt. Wobei

der Wert auch leer sein darf.

- Der XPath-Ausdruck

für den Namen (Extract Name): Dieser Ausdruck

wird auf jedes gefunden Element angewendet um den Namen zu extrahieren.

- Der XPath-Ausdruck

für den Wert (Extract Value): Dieser Ausdruck

liefert den Wert des Elements.

Die Kombination aus diesen drei Ausdrücken

wird als BA-Muster (BA-Expression)

bezeichnet. Die Elemente, die mit Hilfe eines BA-Musters gefunden werden,

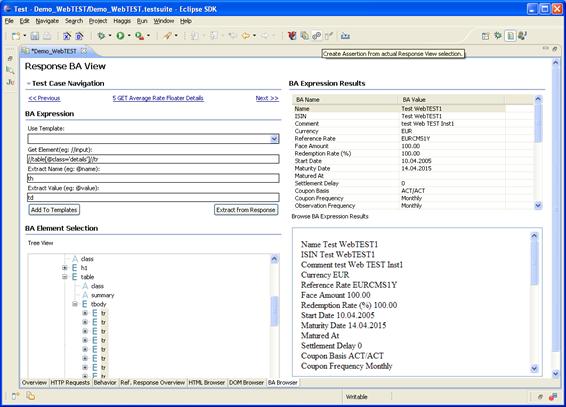

werden als Business-Attribute-Instances (BAIs) bezeichnet. Abbildung 3.25 zeigt die “BA Browser”-Seite. Auf dieser Seite

wurde der aktive Response („5 Get Average Rate Floater Details“) bereits mit dem

in der Abbildung dargestellten BA-Muster analysiert. Deshalb sind in der

Tabelle auf der rechten oberen Hälfte unter der Überschrift „BA Expression

Results“ bereits BAIs dargestellt. In

der Tabelle der oberen Hälfte werden Namen und Werte der BAIs als Text

dargestellt. Da diese jedoch wieder HTML-Elemente enthalten können, werden in

einem HTML-Browser-Feld darunter alle Elemente nochmals dargestellt, wie sie in

einem Web-Browser angezeigt werden.

Abbildung 3.25: Die BA-Browser-Seite des

Test-Editors nach Auswahl des Templates „UnRisk Detail Table Template“

Um den in Abbildung 3.25 dargestellten Zustand herzustellen, müssen folgende

drei Schritte durchgeführt werden:

- Mit Hilfe der „Test Case Navigation“, muss

der aktive Request auf „5 GET Average Rate Floater Details“ gesetzt

werden.

- Danach muss in der Combo-Box „Use Template“

das BA-Template „UnRisk Detail Table Template“ ausgewählt werden. Dabei

werden die XPath-Ausdrücke für Element, Name und Wert ausgefüllt. Ein

BA-Template ist ein vordefiniertes BA-Muster mit einem Namen.

- Schließlich kann der Button „Extract from

Response“ verwendet werden, um die Elemente beziehungsweise die BAIs des

aktiven Responses zu extrahieren. Dabei werden die BAIs in eine Tabelle

und in einem HTML-Browser auf der rechten Hälfte der Test-Editor-Seite

eingetragen.

Nun ist es möglich, eine

BA-Assertion generieren zu lassen, die das eingestellte BA-Muster und die im

aufgenommen Response gefunden BAIs verwendet. Dazu steht wieder die

Create-Assertion-Aktion ( )

zur Verfügung.

)

zur Verfügung.

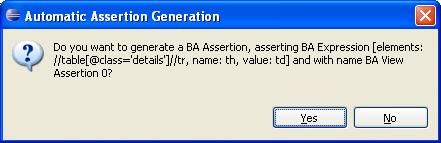

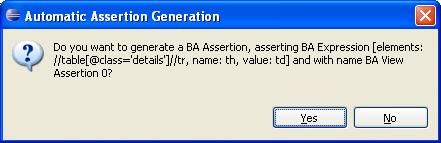

Abbildung 3.26: Der Automatic-Assertion-Generation-Dialog für eine BA-Assertion

Wie Abbildung 3.26 darstellt, wird mit dieser Aktion in diesem Kontext

eine BA-Assertion erstellt. Diese Assertion überprüft bei der Ausführung, ob im

Response das BA-Muster ausgewertet werden kann und alle Elemente mit den

richtigen Werten in der korrekten Reihenfolge gefunden werden. Bei der Testausführung

müssen also alle Werte, wie sie in der BAI-Tabelle von Abbildung

3.25 dargestellt sind, gefunden

werden. Zum Erstellen der BA-Assertion wird aus jedem BAI der BAI-Tabelle von Abbildung 3.25 ein Basiskriterium erstellt und mit dem BA-Kriterium

der Assertion verknüpft. Das BA-Kriterium enthält das zu prüfenden BA-Muster.

Diese BA-Assertion wird nun automatisch durch bestätigen des Dialogs in Abbildung 3.26 erstellt. Eine detaillierte Erläuterung des

BA-Kriteriums folgt in Kapitel 3.3.4 „Bearbeiten der Assertions“. Dort wird unter anderem auch gezeigt, wie man

unerwünschte BAIs wieder aus dem Kriterium entfernt.

BA-Templates

Im Laufe der Verwendung des BA-Musters in

Web-TEST wurde eine wichtige Entdeckung gemacht: Man benötigt nur eine kleine

Menge von verschiedenen BA-Mustern, um nahezu alle Responses einer speziellen

SUT analysieren zu können. Folgende Eigenschaften von HTML-basierten

Webanwendungen können dafür verantwortlich gemacht werden:

- HTML verwendet standardisierte Elemente zur Darstellung und

Eingabe von Werten wie etwa Input- und Select-Felder. Informationen werden

etwa oft in zweispaltigen Tabellen im zentralen Bereich der Ansicht

dargestellt. Wobei die erste Spalte meist den Titel und die zweite Spalte

den Inhalt der Information darstellt. Auch UnRisk-FACTORY verwendet dieses

Schema wie in der Einleitung schon gezeigt.

- Webanwendungen verwenden meist für alle HTML-Seiten ein

einheitliches Schema. Die Struktur der Informationen auf den verschiedenen

HTML-Seiten ist also identisch.

Durch Eigenschaft 1 ist es möglich

allgemeine BA-Muster zu definieren und diese für alle Responses, in denen

beispielsweise Input-Felder vorkommen, zu verwenden. Das BA-Muster für

Input-Felder sieht immer gleich aus und kann deshalb als BA-Template in

Web-TEST vordefiniert werden. Weiters ermöglicht Punkt 2, dass ein BA-Muster

für viele HTML-Seiten einer bestimmten SUT verwendet werden kann. Web-TEST

ermöglicht es deshalb, zusätzliche BA-Templates zu definieren. Dadurch erspart

man sich die Eingabe der drei XPath-Ausdrücke beim Eingeben eines BA-Musters.

Im Beispiel von Abbildung 3.25 wurde bereits eines dieser vordefinierten Templates

(„UnRisk Detail Table Template“), das

speziell auf die Informationsdarstellung von UnRisk-FACTORY eingestellt wurde,

verwendet.

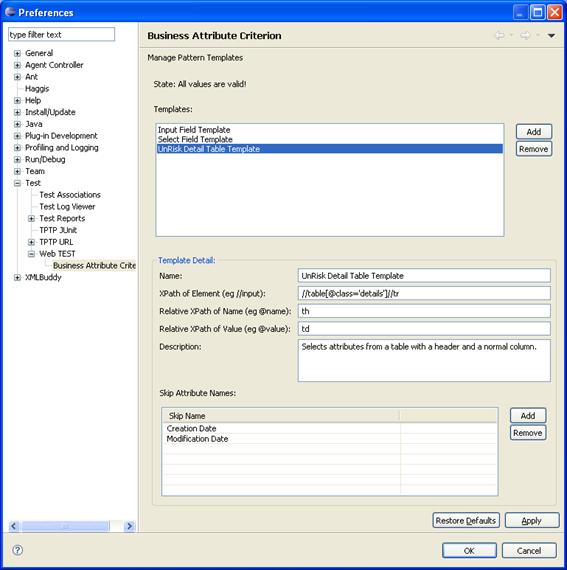

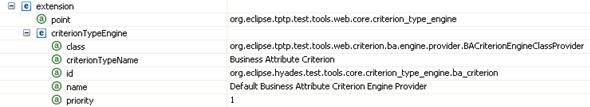

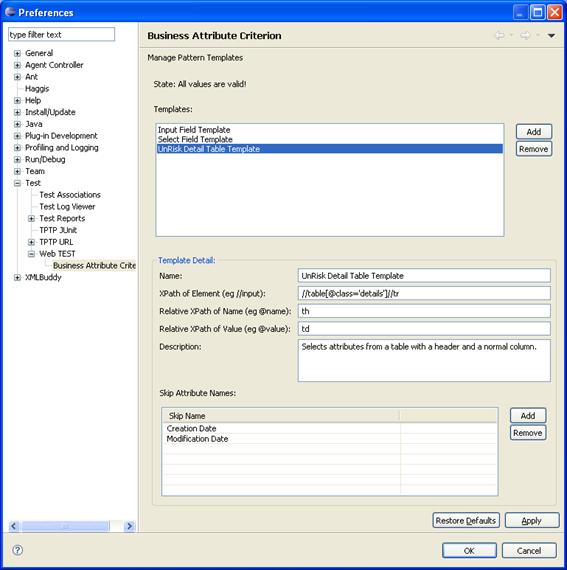

Abbildung

3.27: Konfiguration von

BA-Templates

Abbildung

3.27 zeigt die drei von Web-TEST Version 1.0 standardmäßig

vordefinierten BA-Templates. Zu finden ist die Eclipse-Einstellungsseite zum

Verwalten der BA-Templates unter dem Menu „Window/Preferences …“ und dem Pfad

„Test/Web-TEST/Business Attribute Criterion“. Hier können die BA-Templates

geändert, erstellt oder gelöscht werden. Zusätzlich zu dem BA-Muster kann man

auch noch einen Namen, eine Beschreibung sowie Skip-Names

(Skip-Attribute-Names) angeben. Skip-Names sind Namen von Elementen die

ignoriert werden sollen. Diese Skip-Names werden ausschließlich im BA-Assertion-Generation-Wizard

( )

verwendet.

)

verwendet.

Der

BA-Assertion-Generation-Wizard wird über die gleichnamige Aktion aufgerufen. Die

Aktion steht sowohl im Assertion- wie auch im Test-Editor zur Verfügung.

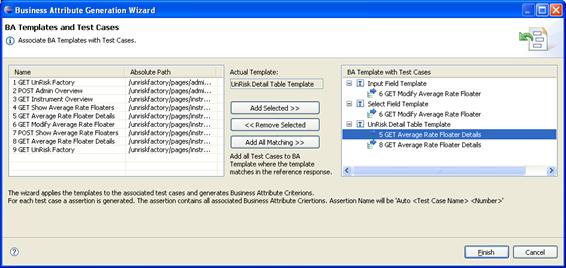

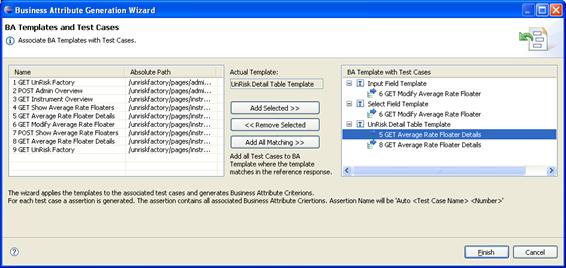

Abbildung 3.28: Der BA-Assertion-Generation-Wizard

Abbildung 3.28 zeigt den BA-Assertion-Generation-Wizard. Der

Wizard kann zur automatischen Generierung einer Menge von BA-Assertions

verwendet werden. Auf der linken Seite werden alle Requests in einer Tabelle

angezeigt. Auf der rechten Seite werden alle vordefinierten BA-Templates und

die zugeordneten Requests in einem Baum angezeigt.

Die Requests können mit

dem „Add Selected >>“-Button zum aktuellen BA-Template im Baum zugeordnet

werden. Das aktuelle Template wird dabei in der Mitte des Wizards oben unter

der Bezeichnung „Actual Template:“ angezeigt und kann durch Auswahl eines

anderen Knotens im Baum geändert werden.

Weiters kann über den

Button „Add All Matching >>“ ein Dienst aufgerufen werden, der alle sinnvollen

Kombinationen von Requests und BA-Templates in den Baum rechts einträgt. Dabei

wird jedes BA-Template in jedem aufgenommenen Response ausgeführt. Wenn

zumindest ein Element im Response gefunden wird, dessen Name nicht in den

Skip-Namen des BA-Templates enthalten ist, dann wird der zugehörige Request zu

dem verwendeten BA-Template im Baum eingetragen. In Abbildung 3.28 wurde dieser Button bereits benützt und alle sinnvollen BA-Assertions

werden vorgeschlagen. Hinweis: Da für den Request „5 GET Average Rate Floater

Details“ bereits manuell eine BA-Assertion erstellt wurde, ist es sinnvoll,

diesen Request mittels „<< Remove Selected“-Button wieder aus dem Baum zu

entfernen.

Darauf hin kann mit

„Finish“ der Vorschlag bestätigt und der Wizard beendet werden. Dabei erscheint

eine Meldung, dass die Testressource im Dateisystem geändert wurde. Diese

Meldung muss mit „Yes“ bestätigt werden, damit alle Änderungen in der Testressource

gespeichert werden. Schließlich wird man auf die „Behavior“-Seite des Test-Editors geleitet.

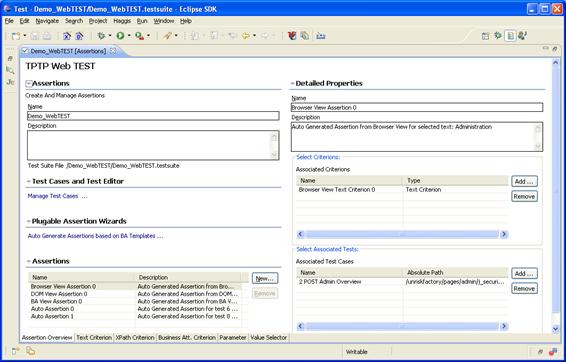

Nachdem man mit Hilfe des

Test-Editors die nötigen Assertions angelegt hat, kann man im Assertion-Editor

die Assertions überprüfen und sie noch anpassen. Dazu verwendet man wieder die

Aktion Change-Web-TEST-Editor ( ),

um diesmal vom Test-Editor auf den Assertion-Editor zu wechseln. Dabei wird man

auf die, in Abbildung 3.29 dargestellte, „Assertion Overview“-Seite des

Assertion-Editors geleitet.

),

um diesmal vom Test-Editor auf den Assertion-Editor zu wechseln. Dabei wird man

auf die, in Abbildung 3.29 dargestellte, „Assertion Overview“-Seite des

Assertion-Editors geleitet.

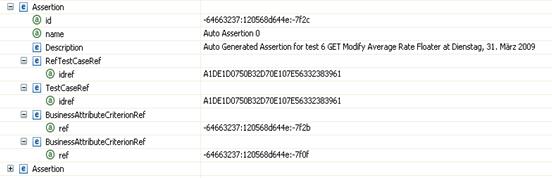

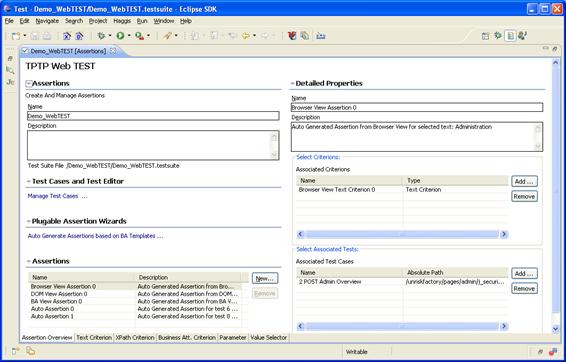

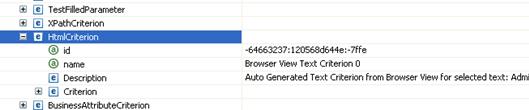

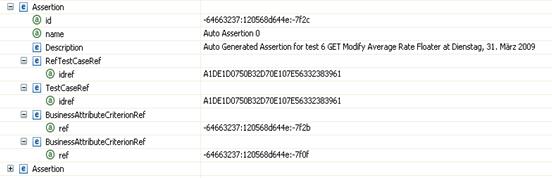

Die Übersicht der Assertions in der Testressource

Abbildung 3.29: Die Assertion-Overview-Seite

des Assertion-Editors

Man sieht nun alle

erzeugten Assertions in einer Tabelle links unten in der „Assertion

Overview“-Seite. Abbildung

3.29 zeigt, dass in diesem Szenario fünf Assertions

angelegt wurden. Von den Namen der Assertions kann abgeleitet werden, aus

welcher Seite des Test-Editors diese erstellt wurden. Eine Assertion wurde von

der „HTML Browser“-Seite, eine von der „DOM Browser“-Seite, eine von der „BA

Browser“-Seite aus erstellt. Die beiden übrigen Assertions wurden durch den

BA-Assertion-Generation-Wizard angelegt. Diese werden mit dem Namen „Auto

Assertion“ und einer laufenden Nummer gekennzeichnet.

Man kann nun die Details

der einzelnen Assertions auf der rechten Seite betrachten und editieren. In Abbildung 3.29 ist die Assertion „Browser View Assertion 0“

ausgewählt und man sieht, dass sie aus einem Text-Kriterium („Browser View Text

Criterion 0“) besteht und dass diese Assertion dem Request „2 POST Admin Overview“

zugeteilt wurde.

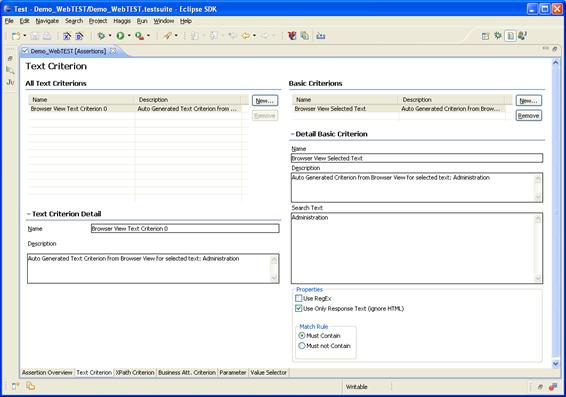

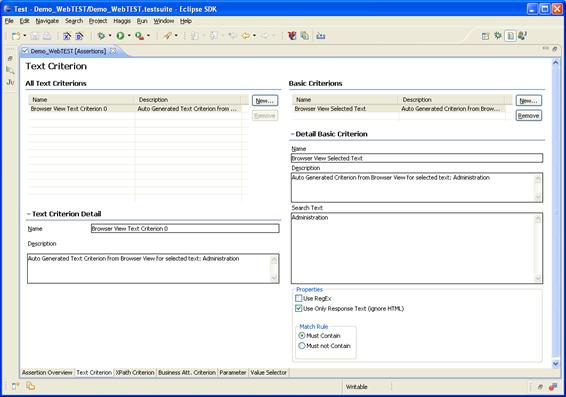

Bearbeiten von Text-Kriterien

Auf der Seite „Text

Criterion“ kann man das verwendete

Text-Kriterium weiter bearbeiten. Abbildung

3.30 zeigt diese Seite mit den Details des Kriteriums

„Browser View Text Criterion 0“.

Abbildung 3.30 Die Text-Criterion-Seite des

Assertion-Editors

Auf dieser Seite können

Text-Kriterien erstellt, gelöscht und bearbeitet werden. Ein Text-Kriterium hat

einen Namen, eine Beschreibung und eine Menge von Basiskriterien. Weitere

Basiskriterien können hinzugefügt, entfernt und editiert werden. Für

Basiskriterien von Text-Kriterien kann man folgende Eigenschaften festlegen:

- Name (Name)

- Beschreibung (Description)

- Wert (Search Text)

- Werden reguläre Ausdrücke im Wert verwendet

(Use RegEx)

- Soll nur der Textinhalt eines Responses ohne

den HTML-Tags und -Attributen überprüft werden (Use Only Response Text (ignore

HTML))

- Vergleichsoperation: der Wert muss enthalten

sein oder der Wert darf nicht enthalten sein (Match Rule: Must Contain vs.

Must not Contain)

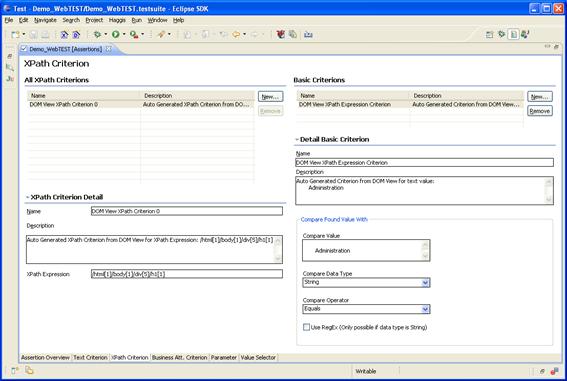

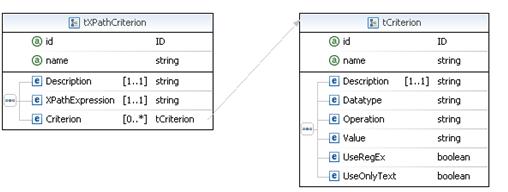

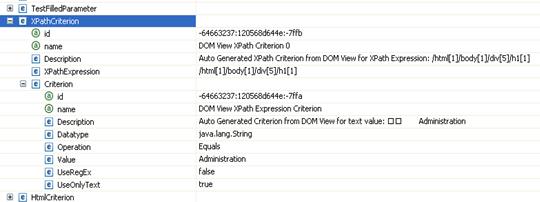

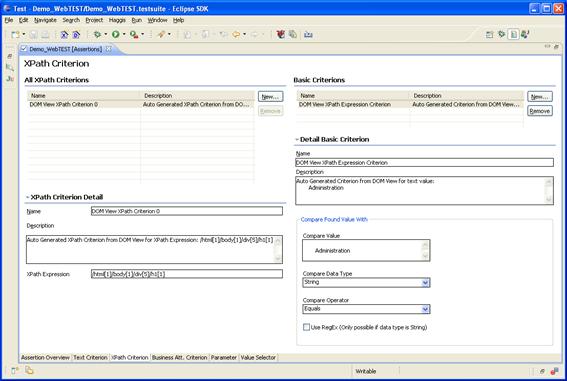

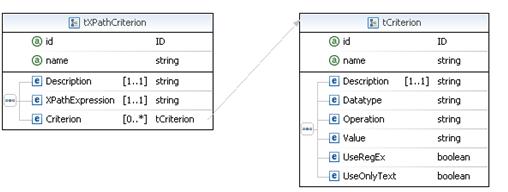

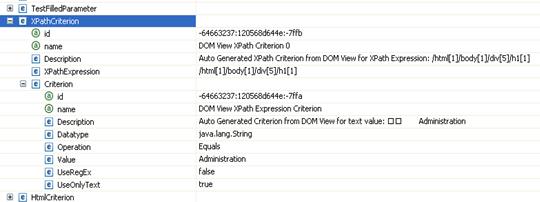

Bearbeiten von XPath-Kriterien

Auch die XPath-Kriterien

können auf ähnliche Weise gewartet werden. Hierfür steht die Seite „XPath

Criterion“, wie in Abbildung

3.31 gezeigt, zur Verfügung.

Abbildung 3.31: Die

XPath-Criterion-Seite des Assertion-Editors

Auf dieser Seite können XPath-Kriterien

erstellt, gelöscht und bearbeitet werden. Ein XPath-Kriterium hat einen Namen,

eine Beschreibung, einen XPath-Ausdruck (XPath-Expression) und eine Menge von

Basiskriterien. Auch hier können Basiskriterien hinzugefügt, entfernt und

editiert werden. Für Basiskriterien von XPath-Kriterien kann man folgende

Eigenschaften festlegen:

- Name (Name)

- Beschreibung (Description)

- Wert (Compare Value)

- Datentyp (Compare Data Type)

- Vergleichsoperator (Compare Operator)

- Werden reguläre Ausdrücke im Wert verwendet

(Use RegEx (Only

possible if data type is String))

Als Datentyp stehen

„String“, „Integer“ oder „Double“ zur Verfügung. Weiters werden folgende

Vergleichsoperatoren unterstützt: „Equals“, „Not Equal“, „Less Than“, „Greater

Than“, „Contains“ und „Doesn’t Contain“.

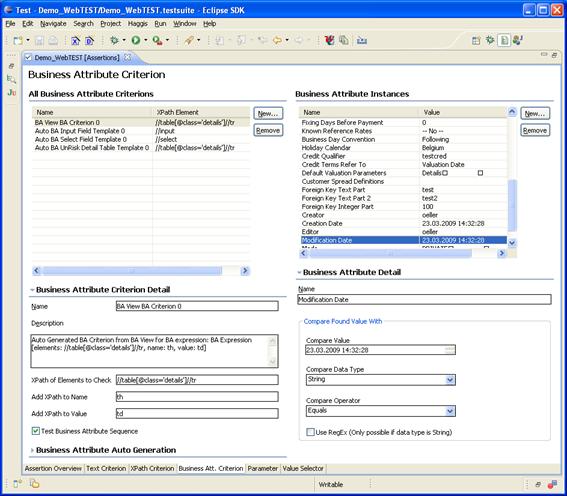

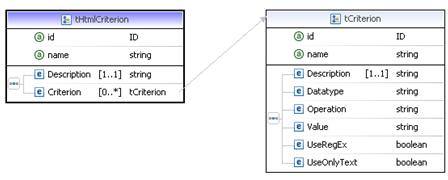

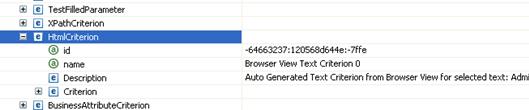

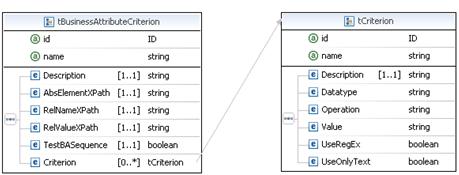

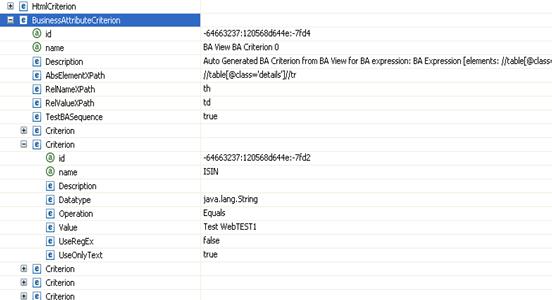

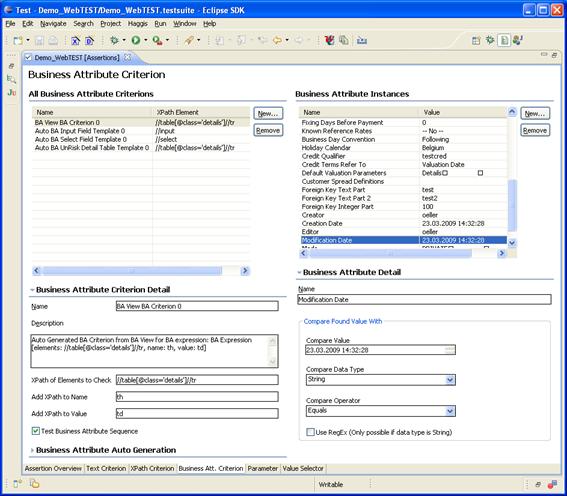

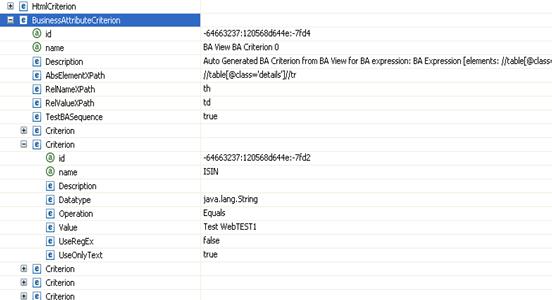

Bearbeiten von BA-Kriterien

Schließlich können auch

BA-Kriterien auf der Seite „Business Att. Criterion“ bearbeitet werden. Abbildung 3.32 zeigt diese Seite mit den BA-Kriterien, die im Rahmen

des Anwendungsfalls bereits erstellten wurden.

Abbildung

3.32: Die BA-Criterion-Seite des Assertion-Editors

Mit Hilfe der linken Hälfte

der Seite können BA-Kriterien erstellt, gelöscht und bearbeitet werden. Ein

BA-Kriterium hat einen Namen, eine Beschreibung, ein BA-Muster, einen Schalter

„Test Business Attribute Sequence“ und

eine Menge von Basiskriterien, die in diesem Rahmen wieder als „Business

Attribute Instances“ (BAIs) bezeichnet

werden. Der Schalter „Test Business Attribute Sequence“ garantiert, dass bei

der Testausführung die BAIs in der gleichen Reihenfolge gefunden werden, wie

sie im BA-Kriterium definiert sind. Wieder können Basiskriterien hinzugefügt,

entfernt und editiert werden.

Weiters gibt es auch über

den Punkt „Business Attribute Auto Generation“ die Möglichkeit, automatisch

zusätzlich Basiskriterien zu einem BA-Kriterium hinzuzufügen. Ähnlich wie in

der Abbildung 3.25, die die BA-Browser-Seite des Test-Editors

beschreibt, kann man auch hier wieder ein BA-Template und einen Request wählen.

Man kann aus diesem Request alle Elemente extrahieren, die dem angegebenen

BA-Muster entsprechen. Für die Basiskriterien (die BAIs) von BA-Kriterien

gelten die gleichen Eigenschaften wie für die Basiskriterien von

XPath-Kriterien, mit der Ausnahme, dass keine Beschreibung eingegeben werden

kann. Üblicherweise sind hier nach der automatischen Generierung über den Punkt

„Business Attribute Auto Generation“, über die „BA Browser“-Seite des Test-Editors

oder über den BA-Assertion-Generation-Wizard

kaum mehr Änderungen nötig da beispielsweise auch der Vergleichoperator mit dem

Standardwert „Equals“ vorbelegt wird.

Abbildung

3.32 zeigt auch, dass in dem Szenario vier BA-Kriterien

erzeugt wurden. Wobei am Namen der Kriterien erkennbar ist, dass drei der

Szenarien vom BA-Assertion-Generation-Wizard (Name der Assertions fängt mit

„Auto BA“ an) und eines aus der „BA Browser“-Seite („BA View Criterion 0“)

erzeugt wurden.

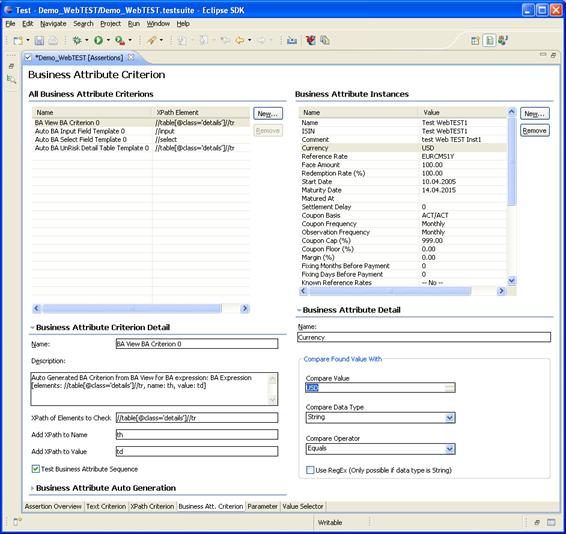

Wenn man nun die Liste

der BAIs des BA-Kriteriums „BA View Criterion 0“ betrachtet, dann findet man dort

die beiden Einträge „Creation Date“ und „Modification Date“. Diese Elemente

sind in den Skip-Namen des BA-Templates enthalten und sind deshalb in den durch

den Wizard erzeugten BA-Kriterien nicht mehr enthalten. Die „BA Browser“-Seite

ignoriert jedoch die Skip-Namen eines BA-Templates, weshalb diese BAIs in der

„BA View Criterion 0“ noch enthalten sind. Normalerweise werden

BA-Kriterien für die es schon ein

BA-Template gibt mit dem

BA-Assertion-Generation-Wizard erzeugt und die „BA Browser“-Seite wird

lediglich zum Testen neuer BA-Templates verwendet.

Es ist sehr

wahrscheinlich, dass sich das „Modification Date“ in der von dem BA-Kriterium

„BA View Criterion 0“ getesteten

HTML-Seite beim späteren Abspielen des Tests ändert. In diesem Fall bekommt man

eine Meldung, dass dieses Kriterium nicht erfüllt wird. Im Regelfall werden

deshalb die Attribute, die sich ändern dürfen, aus der Liste der BAIs entfernt.

Dies kann mit dem „Remove“-Button neben der BAI-Tabelle erledigt werden.

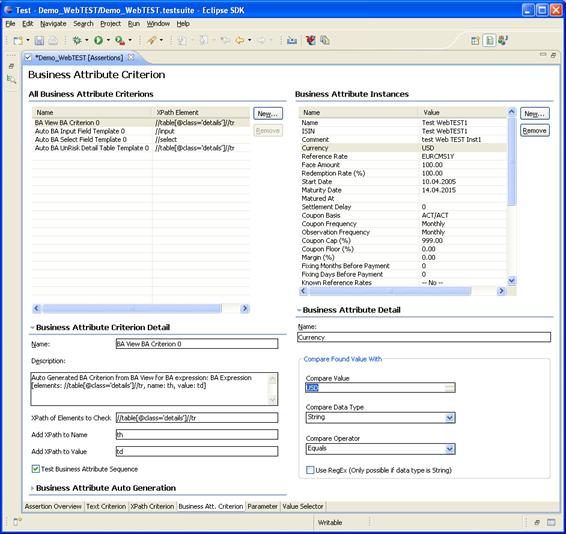

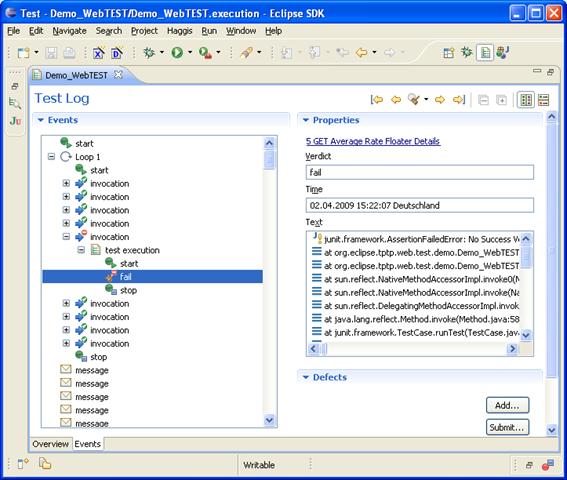

In diesem Anwendungsfall

soll auch gezeigt werden, was passiert, wenn eine Assertion nicht erfüllt wird.

Deswegen wird hier die BAI mit dem Namen „Currency“ auf einen Wert gesetzt, der

bei der Testausführung nicht gefunden werden kann. Dazu kann einfach die BAI

„Currency“ aus der Tabelle ausgewählt werden und der „Compare Value“ von „EUR“

auf „USD“ umgestellt werden.

Abbildung

3.33: Ändern des Werts des Currency-BAIs auf "USD"

Abbildung

3.33 zeigt diese Änderung im BA-Kriteriums „BA View

Criterion 0“. Beim Ausführen des Tests wird nochmals darauf hingewiesen, dass

mit Absicht eine Assertion erzeugt wurde, die einen Fehler liefern muss. Es

wird auch gezeigt, dass Web-TEST diesen Fehler richtig erkennt.

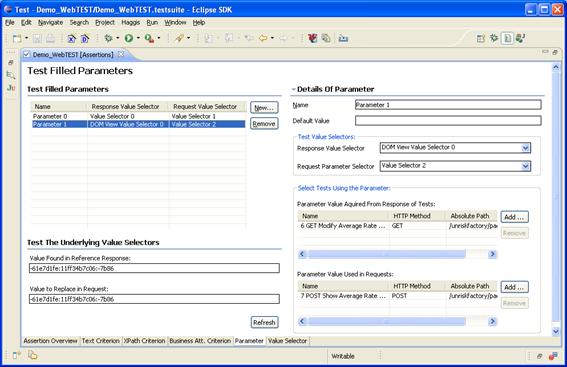

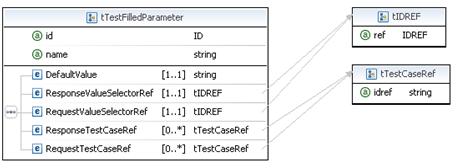

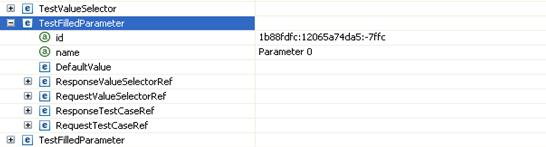

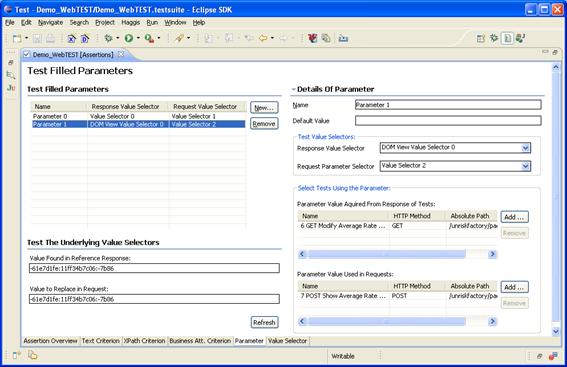

Neben der Definition von

Assertions können im Assertion-Editor auch dynamische Request-Parameter erstellt werden. Diese Parameter können

beispielsweise eingesetzt werden, um lange Transaktionen zu unterstützen. Als

lange Transaktionen bezeichnet man im Bereich von Webanwendungen Transaktionen,

die mehrere Request benötigen. UnRisk-FACTORY verwendet lange Transaktionen

etwa für das Editieren von Objekten. Dabei werden beim Erzeugen einer

HTML-Seite, die zum Editieren eines Objekts dient, bereits alle

Objekteigenschaften am Webserver gespeichert. Dem Benutzer wird dann die

HTML-Seite mit einem zusätzlichen, versteckten Identifikationsfeld gesendet.

Der Wert des Identifikationsfelds referenziert die am Webserver gespeicherten

Objektdaten. Wenn der Benutzer von UnRisk-FACTORY seine Änderungen bestätigt,

dann wird dieser Wert in den Bestätigungs-Request aufgenommen und an den Server

gesandt. Der Server kann so auf die bereits gespeicherten Daten zugreifen und

die neuen Änderungen eintragen. Das Problem beim Abspielen ist, dass der Wert

des Identifikationsfelds am Webserver beim Aufnehmen nicht der gleiche ist wie

beim Abspielen. Der Bestätigungs-Request kann also beim Abspielen nicht mehr

den gespeicherten Wert des Identifikationsfeldes verwenden, sondern muss den

neuen Wert des Webservers verwenden.

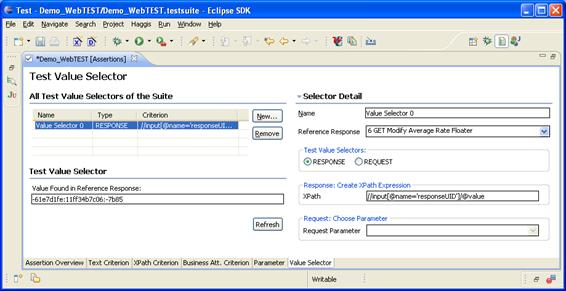

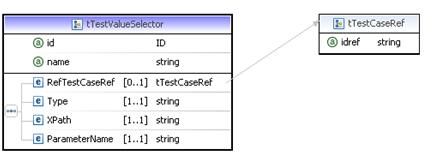

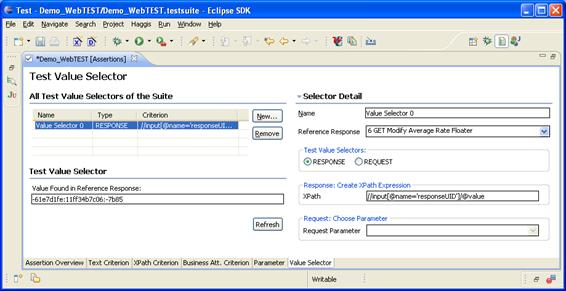

Web-TEST löst dieses

Problem mittels dynamischer Request-Parameter. Dynamische Request-Parameter

werden mit Hilfe eines Response-Value-Selectors

aus einem Response gelesen und durch einen Request-Value-Selector

in einem folgenden Request verwendet. Ein Response-Value-Selector definiert

einen XPath-Ausdruck, der einen Wert aus dem Response extrahiert. Ein Request-Value-Selector definiert einen

Request-Parameternamen, als dessen Wert der zuvor gefundene Wert verwendet

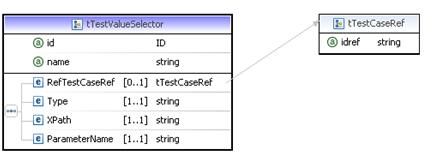

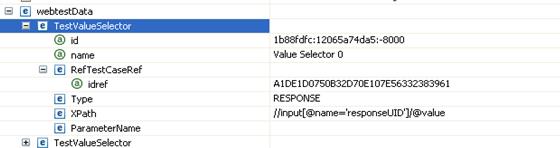

werden soll. Abbildung 3.34 zeigt die Definition eines Response-Value-Selectors.

Abbildung 3.34: Die Value-Selector-Seite des

Assertion-Editors

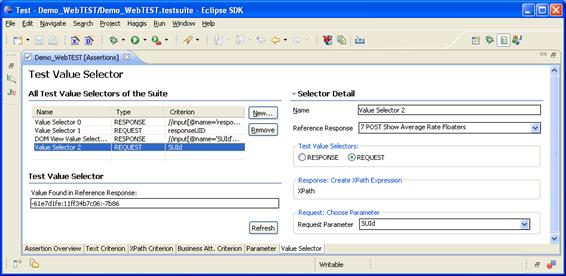

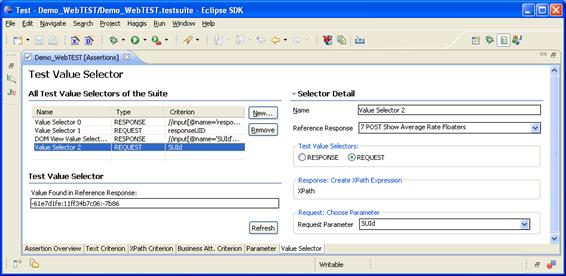

Um den in Abbildung 3.34 dargestellten Zustand nachzustellen, muss man mit dem

Button „New…“ einen neuen Value-Selector anlegen. Dabei wird als Standardtyp

„Response“ ausgewählt. Danach muss man einen XPath-Ausdruck festlegen. In

diesem Beispiel muss „//input[@name='responseUID']/@value“ eingegeben werden.

Als Referenz-Response

(Reference-Response) muss „6 GET Modify Average Rate Floater“ ausgewählt

werden. Mit Hilfe dieses Response-Value-Selectors wird im Response nach einem

Input-Feld mit Namen „responseUID“ gesucht. Um den Response-Value-Selector in einem

Referenz-Response zu testen, kann der „Refresh“-Button verwendet werden. Dabei

wird der gefunden Wert links unten im Punkt „Test Value Selector“ angezeigt.

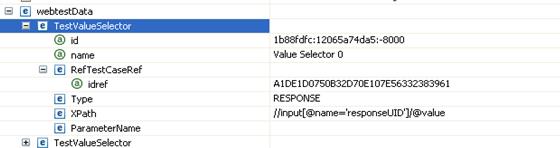

Um nun einen dynamischen

Request-Parameter für das Feld „responseUID“ erzeugen zu können, muss noch ein

Request-Value-Selector erstellt werden. Dazu klickt man wieder auf den „New

…“-Button, wählt als Typ „Request“ aus und stellt als Referenz-Response „7 POST

Show Average Rate Floaters“ ein. Schließlich wählt man als

Request-Parameternamen (Request-Parameter) „responseUID“ aus.

UnRisk-FACTORY benötigt

jedoch noch einen zweiten Parameter mit Namen „SUId“ um eine lange Transaktion

durchführen zu können. Man kann hier nach dem gleichen Schema wie für

„responseUID“ vorgehen, um Response- und Request-Value-Selector zu erzeugen.

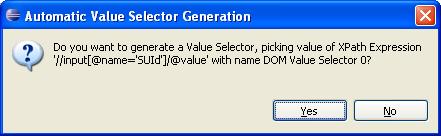

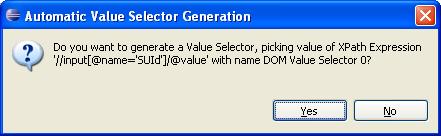

Es gibt jedoch eine

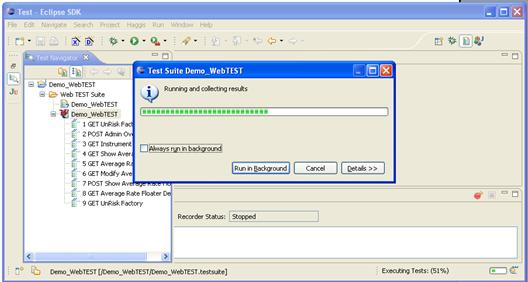

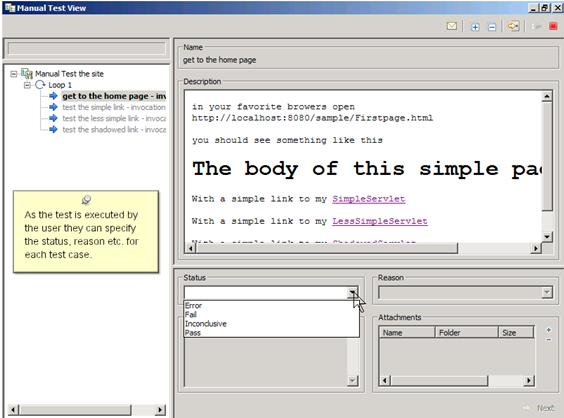

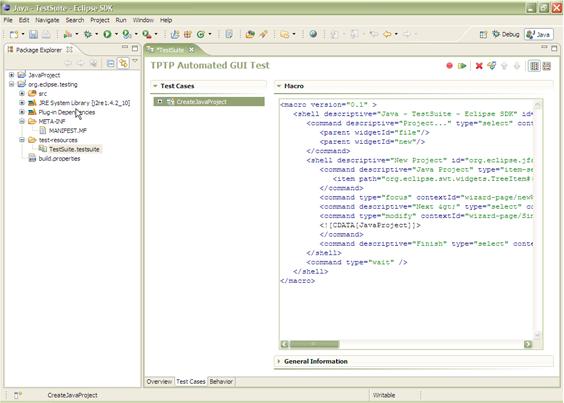

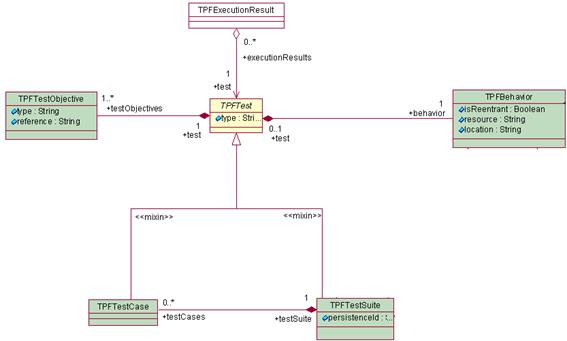

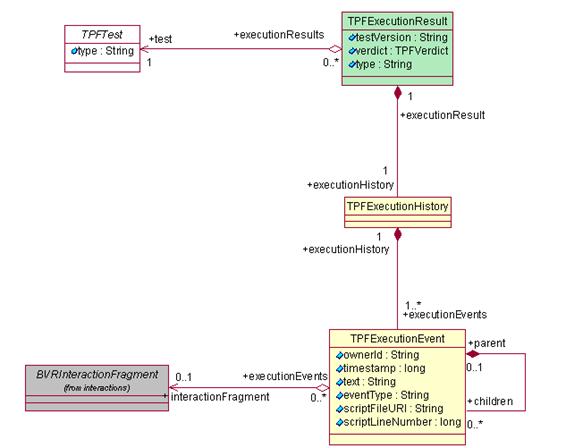

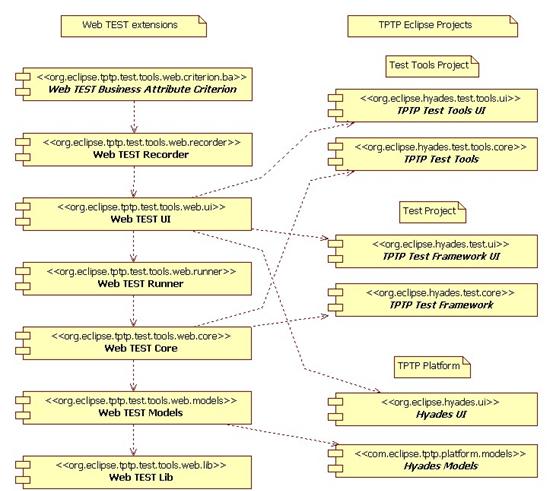

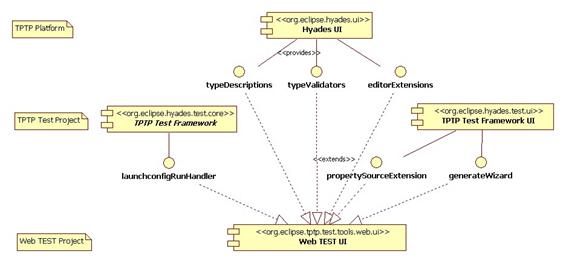

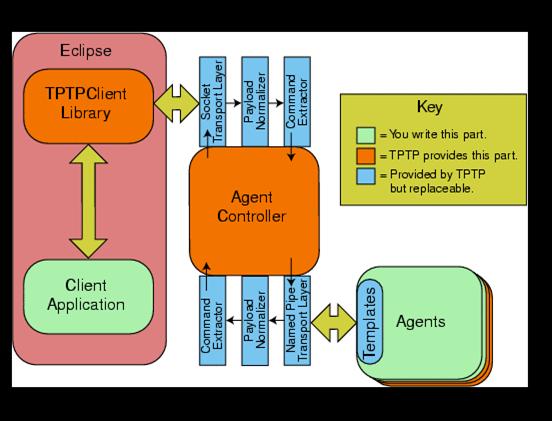

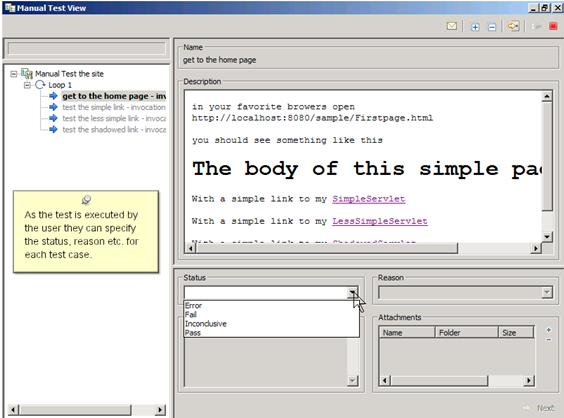

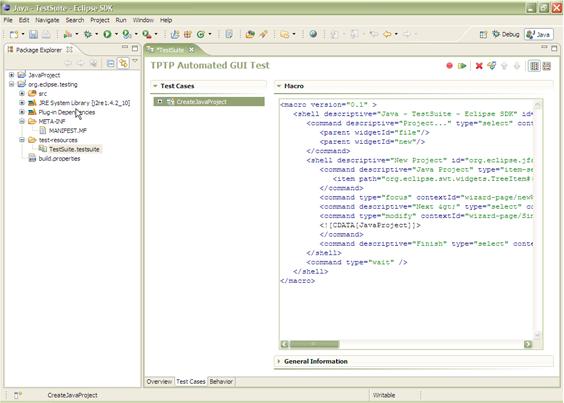

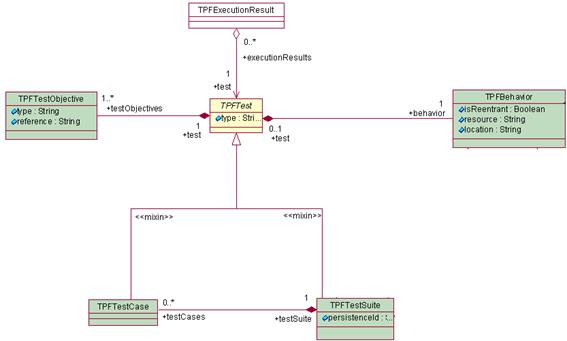

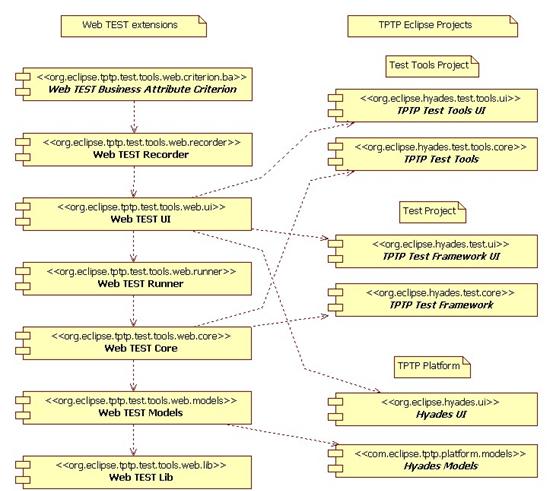

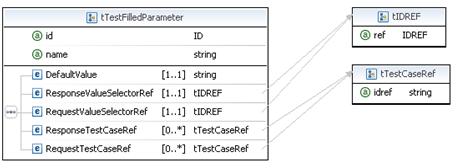

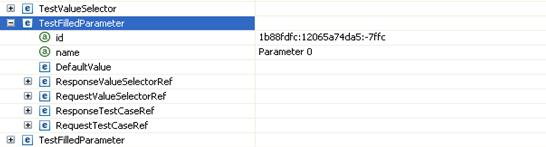

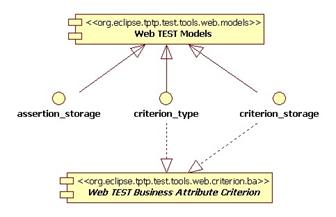

benutzerfreundlichere Alternative um den Response-Value-Selector zu erzeugen,